The common way to obtain a stereoscopic image of a subject at a distance is to place two cameras on the parallel axis rather than crossing axis. To find the IAD and maximum focal length, left and right images are obtained by varying the IAD of cameras and the focal length of the camera lens and the depth budget for the obtained images is analyzed through post production. Then, the database for IAD and focal length of the camera lens with the depth range that does not cause visual fatigue and visual discomfort are developed. These data are used to design fuzzy control and deduce the IAD and focal length of the camera lens to shoot a subject at a distance, and the function of the fuzzy control is confirmed through the actual shooting within the range of deduced IAD and focal length of the camera lens.

3D 입체영상은 실재감 재현효과가 우수하여 의료, 우주항공, 극한산업, 영상오락, 방위산업, 방송 등의 다양한 분야에서 필요로 한다. 3D 입체영상은 영상획득 및 제작 기술과 재현 기술로 구분된다. 영상획득 방식은 양안시차를 응용한 3D 스테레오 카메라를 이용하여 직접 촬영하는 방식과 컴퓨터 그래픽을 이용하여 가상 카메라를 통해 획득하는 방식, 두 가지를 결합하여 사용하는 하이브리드 방식, 일반 2D 영상을 3D 입체영상으로 변환하는 컨버팅 방식 등으로 나눌 수 있다. 3D 입체영상의 재현 기술은 크게 안경식과 무안경식, 홀로그램 방식으로 구분할 수 있다. 입체영상 재현 기술 분야와 달리 고품질의 입체영상을 제작하는 기술은 관련 소프트웨어와 체계적인 제작 워크플로우의 부재라는 측면에서 게임분야를 제외하고는 미진한 상태이다[1].

3D 입체영상 획득은 두 대의 좌우 카메라를 사용하는데, 동일한 영상 카메라와 동일한 광학 렌즈를 사용하게 되면 사람이 양안을 통하여 일반 사물을 보는 것과 같이 동일한 특성의 좌우 영상을 전달할 수 있다. 이때 입체영상을 얻기 위해서 좌우 카메라 렌즈 중심 간의 축간거리(IAD, Inter Axial Distance)를 어느 정도로 할지와 카메라의 주시각을 어떻게 배치할 지가 입체감을 좌우하는 중요한 파라미터이다. 카메라의 주시각에 따라 교차식과 수평식으로 나눌 수 있다. 교차식은 좌우 카메라의 주시각을 교차시켜 촬영하는 방법으로 주시각이 교차되는 주시점에서는 시차가 0인 화면 재생 포인트가 된다. 또한 주시점보다 앞에 있는 부분은 입체영상 시청 시 스크린 보다 돌출되어 보이고, 주시점 뒤에 있는 부분은 스크린 뒤쪽으로 들어가 보인다. 그러나 주시각을 교차하는 방식으로 주시점을 가까운 쪽에 설정하고 원거리를 촬영하면 좌우 배경영상의 시차가 지나치게 커져서 시각적 피로감을 주게 된다. 수평식은 좌우 카메라의 주시각을 평행하게 유지하면서 영상을 획득하는 방식으로, 수평식으로 촬영한 영상을 그대로 제시하면 피사체가 화면의 앞쪽으로 나온다. 따라서 후반작업에서 적절하게 보정하면 원거리 피사체에 대하여 교차법보다 왜곡이 적은 입체감을 재생할 수 있다[2-4]. 3D 입체영상의 제작에서 두 영상간의 색감, 밝기, blur 등의 영상 특성과 두 카메라의 회전 및 왜곡과 관련된 불일치, 수직시차, 합성하기 어려운 수평시차, 카메라의 동기화 불일치 및 폭주각에 의한 crosstalk 등의 기하학적 특징에 의해 시각적 피로감을 느낄 수 있다. 이러한 문제 중에서 수직시차와 수평시차는 시각피로를 줄이기 위한 중요한 요소이다[5-9].

본 논문에서는 원거리 피사체에 대하여 시각피로를 최소화 할 수 있는 수평시차 범위 내에서 입체영상을 획득할 수 있는 카메라의 축간거리와 카메라 렌즈의 초점거리 범위를 추론하는 기술을 제안한다. 특정 원거리 피사체들에 대하여 카메라의 축간거리와 카메라 렌즈의 초점거리를 변화시켜 가며 영상을 획득하고, 이 영상들에 대한 분석을 통하여 깊이값(depth budget)을 표로 만든다. 이들 데이터를 활용하여 임의의 원거리 피사체에 대하여 피로감 없는 수평시차 범위로 입체영상을 획득할 수 있는 두 카메라간의 축간거리와 카메라 초점거리를 결정하는 퍼지제어기(fuzzy controller)를 설계하고, 이를 바탕으로 실제 원거리 피사체에 대한 입체영상을 획득하고 깊이값 분석을 통하여 퍼지제어기를 통한 축간거리와 카메라 렌즈의 초점거리 범위 추론의 타당성을 입증한다.

촬영장비는 기본적으로 카메라 두 대를 정교하게 동조, 결합시키는 리그(rig)와 입체영상을 실시간으로 모니터링 할 수 있는 입체영상 전용 모니터로 이루어진다.

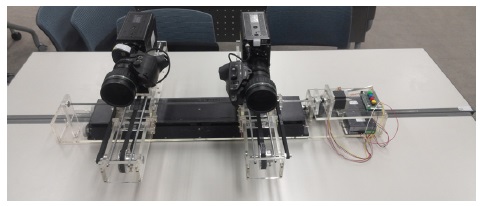

두 대의 카메라를 사용하는 이유는 사람이 입체감을 느끼게 하는 여러 요인 중에서 주로 양안시차를 이용하여 입체영상을 제작하기 때문에 사용되는데, 양안 시차는 오른쪽 눈으로 받아들인 영상과 왼쪽 눈으로 받아들인 영상의 위치 차이를 뇌가 분석하여 입체감을 느끼게 되는 것이다. 이러한 두 대의 카메라를 배치하는 방식에 따라 입체카메라는 평행식과 직교식으로 나뉜다. 평행식은 렌즈의 축간거리 65[mm]를 구현하기가 어렵지만 간단한 구조로 소형화가 가능하고, 직교식은 소형화가 어렵고 정교한 리그가 요구되지만 근접 촬영이 가능하다. 그리고 두 대 카메라를 주시하는 방식에 따라 수평식과 교차식으로 나뉘는데, 교차식은 사람의 눈과 같이 카메라를 회전시켜 주시점을 조절하는 방식으로 구조가 단순한 장점이 있는 반면, 거리와 시차의 관계가 왜곡될 수 있는 문제가 있고 키스톤 왜곡이 생겨서 피로감을 일으킨다. 수평식 입체카메라는 두 대의 카메라를 평행판 위에 카메라가 평행으로만 이동할 수 있게 만든 형식으로 주시점 제어가 필요 없고 원거리 피사체나 고배율 줌이 필요한 장면에서 유리하다. 따라서 본 연구에서는 원거리 피사체를 대상으로 입체영상을 획득하기 위하여 두 대의 카메라를 수평으로 놓고 주시방향을 평행하게 이동시킬 수 있는 수평리그를 제작한다. 그러나 기존의 제품들은 전체 길이가 300mm내외로 원거리 촬영에는 한계가 있으므로, 그림 1과 같이 최대 700mm까지 이동시킬 수 있는 수평리그를 자체 제작하였다[10-11]. 이 리그는 스테레오 베이스라인 제어 및 좌우 카메라 주시각의 회전제어가 가능하도록 한다.

원거리 피사체에 대한 입체영상을 획득하기 위해서 제작된 수평리그에 좌/우 카메라를 설치하게 되는데, 카메라 모듈은 POV(point of view)형식의 디지털 카메라인 소니사의 HDC-P1을 사용하며 렌즈는 니콘 렌즈를 사용하여 좌우 카메라의 줌, 포커스, 아이리스 등의 동일화가 가능하도록 한다.

입체영상 촬영 시 좌우 카메라에서 입력되는 데이터의 믹싱 상태, 즉 두 영상이 결합했을 때 영상의 공간감이나 동기화의 문제를 확인해야 하기 때문에 일반 영상 제작 환경에서 보다 모니터의 중요성이 크다. 입체영상 촬영의 모니터는 좌우 카메라에 장착된 LCD모니터와 외부 모니터 2대를 설치하여 좌우를 따로 보는 방식과 좌우 카메라에서 영상신호를 출력시켜 중소형 3D 모니터에서 보도록 하여 촬영자가 입체영상의 카메라 각도와 영상 상태를 프리뷰하면서 촬영할 수 있도록 한다.

한편, 원거리 피사체에 대한 입체영상을 획득하기 위해서는 원거리 피사체의 거리를 인식할 필요가 있다. 이를 위해서 원거리 피사체의 거리를 인식하는 센서로 RF Transceiver 모듈과 RF Antenna 모듈로 구성된 레이더 센서를 사용한다.

좌우 카메라로 촬영된 좌우 영상을 편집해야 입체 영상이 되기 때문에 색감과 밝기의 차이, 동기화등과 같이 기존 편집에서 발생하지 않던 다양한 문제들이 존재한다. 입체영상 편집의 목표는 두 영상의 시각차를 보정해서 시각적으로 피로하지 않은 편안한 융합이 일어나고 연출의도에 맞는 입체감을 만드는 일이다[12].

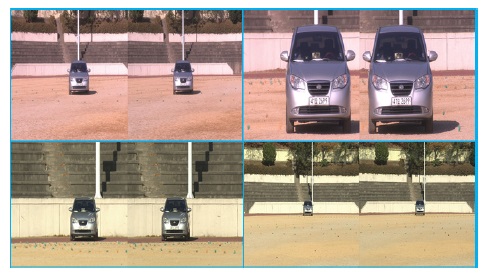

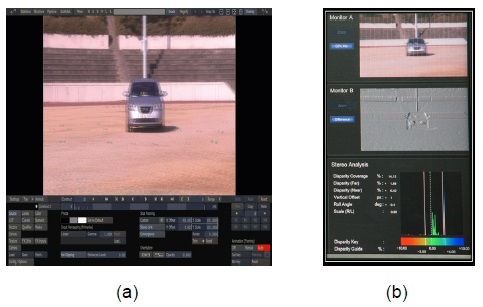

앞에서 제작된 수평리그에 설치된 좌우 카메라를 통하여 원거리 피사체에 대하여 레이더 센서로 피사체와의 거리를 측정하고, 좌우 카메라의 축간거리와 카메라의 초점거리를 변화시켜 가면서 좌우영상을 그림 2와 같이 얻는다.

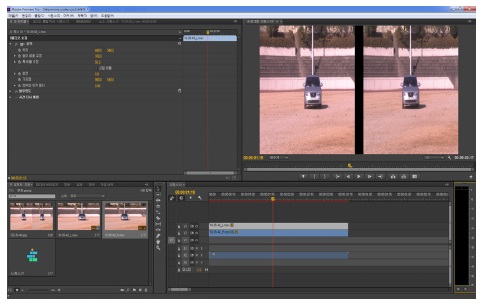

다음 단계는 입체카메라로 획득한 좌우 영상의 데이터 파일을 영상편집 시스템으로 트랜스포트 시킨다. 영상편집 시스템에 입력된 데이터는 입체영상 포맷으로 변환되는 과정을 거치고, 편집 및 합성을 하기 전에 촬영과정에서 어긋난 얼라인먼트(alignment)나 컬러, 밝기의 오차를 보정해야 하는데, 본 연구에서는 비디오 편집소프트웨어 Adobe Premiere Pro를 활용하여 좌우 영상을 그림 3과 같이 편집한다.

한편 수평식 카메라로 촬영된 좌우 영상을 그대로 합성하여 조합하면 동일한 물체의 수평위치의 차이로 인하여 입체감의 깊이를 제공하는 수평시차가 생기지만 과도한 수평시차는 사람이 수용할 수 없는 시각적 피로를 유발하기 때문에 positive 시차는 4% 이내로 하여 들어가는 입체감을 제한하고, negative 시차는 2% 이내로 하여 나오는 입체감을 제한하는 깊이총량(depth budget)을 가진다[13]. 따라서 영상의 합성 및 편집 후 DI(Digital Intermediate)에서 수평시차 조절을 통해 스크린에 영상이 맺히는 영역을 보정함으로써 시각적 피로도를 조절하고 입체감도 조절한다.

수평시차의 조절은 좌우 영상을 그대로 합성하지 않고 좌 또는 우 영상을 약간 더 이동시켜 가면서 합성하여 조합된 영상의 시차가 깊이범위(depth range)내에 있는지 분석하게 된다. 그런데 수평시차 조절을 위해 좌 또는 우 영상을 약간 이동시킨 후 합성하게 되면 이동 된 좌 영상이나 우 영상 부분은 입체감이 없는 영상이 되어 그 부분을 잘라내야 한다. 이것은 의도했던 영상의 정보를 잃게 되는 문제가 생기므로, 좌우 영상을 이동 및 합성하기 전에 자르게 될 영상의 정보부분을 카메라 초점거리를 조절하여 화각범위를 확대하여 둔 후 위의 절차로 영상처리를 한다. 이러한 좌우 영상의 처리작업은 그림 4와 같이 scratch 프로그램을 사용하여 수행한다.

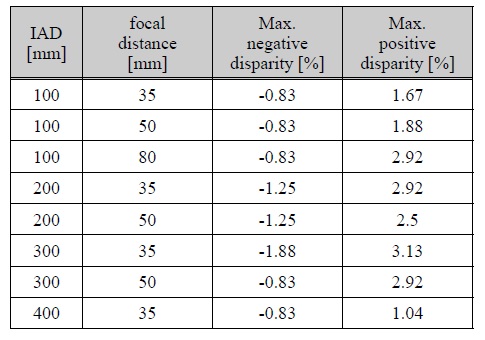

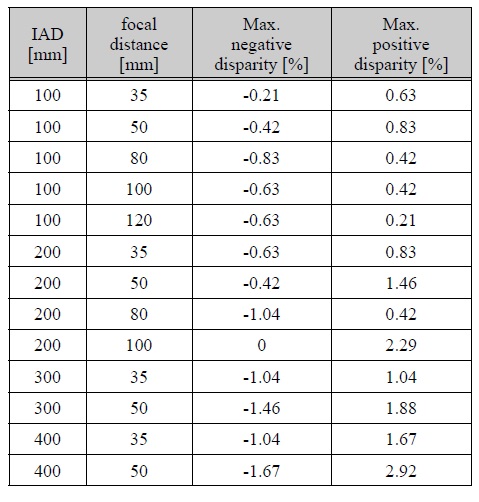

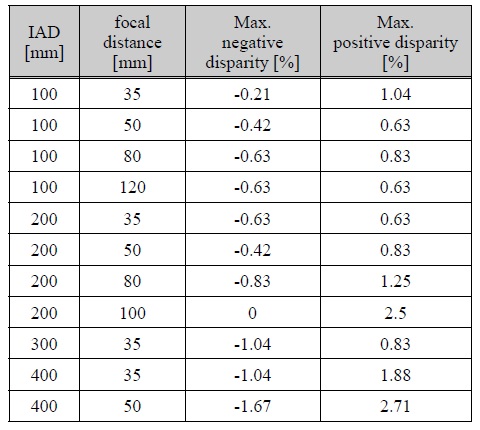

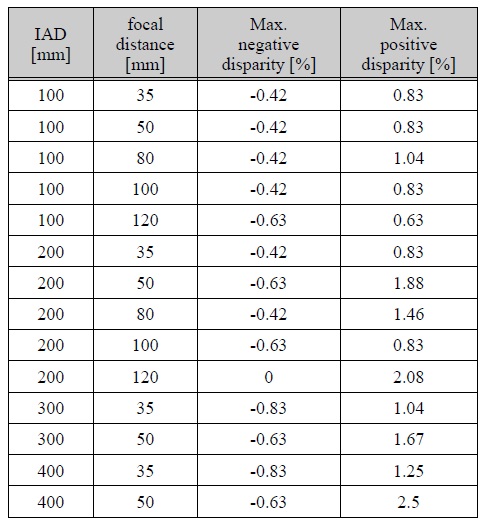

이와 같은 입체영상 획득, 합성 및 분석 실험을 70[m], 80[m], 90[m], 100[m] 거리에 있는 피사체에 대하여 좌우 카메라간의 축간거리와 카메라 렌즈의 초점거리를 변화시켜 가면서 시행하였고, 시각피로도를 고려한 깊이총량 범위내의 입체영상을 얻을 수 있는 카메라 축간거리와 초점거리를 표 1, 2, 3, 4에 정리하였다.

[표 1.] 70[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과

70[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과

[표 2.] 80[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과

80[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과

[표 3.] 90[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과

90[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과

[표 4.] 100[m]에 있는 피사체에 대하여 축간거리와 카메라 초점거리를 변화시키면서 획득한 입체영상의 분석결과

100[m]에 있는 피사체에 대하여 축간거리와 카메라 초점거리를 변화시키면서 획득한 입체영상의 분석결과

퍼지추론(fuzzy inference)은 시스템이 복잡하고 그 시스템에 대한 정보가 불충분하더라도 입력과 출력을 관찰하고 추론을 통하여 입력과 출력간의 관계를 구할 수 있다. 본 연구에서는 표 1, 2, 3, 4에 대한 데이터로부터 임의의 원거리에 있는 피사체에 대하여 시각 피로도를 고려하여 깊이총량 범위 내에서 촬영할 수 있는 입체카메라의 축간거리를 추론하고, 이 축간거리에서 안정감을 고려한 깊이총량 범위내로 화각범위를 조절할 수 있는 카메라의 최대 초점거리를 추론하여 본다[14].

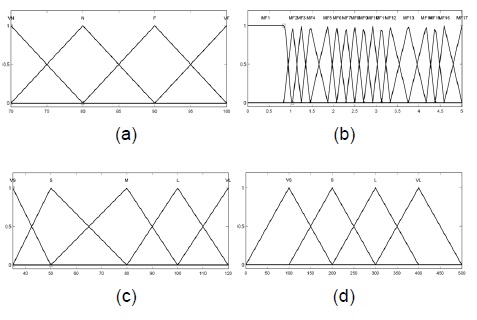

먼저, 임의의 원거리 피사체 촬영용 카메라들의 축간 거리를 결정하는 퍼지제어기에서 입력변수들은 피사체의 거리(D), 깊이총량(DB)과 초점거리(F)로 하고 출력변수는 두 카메라의 축간거리(IAD)로 한다. 이때 피사체의 거리 입력은 70~100[m] 구간을 4단계(VN, N, F, VF)로 분류하고, 입체감의 깊이총량은 안정감있는 범위인 positive(4%)이내에서 negative(2%)이내의 17단계 (MF1~ MF17)로 분류하고, 초점거리는 30~120[mm]까지의 값을 5단계(VS, S, M, L, VL)로 분류하며, 출력변수인 축간거리는 0~500[mm]까지의 4단계(VS, S, L, VL)로 분류하였으며, 구체적인 내용은 그림 5와 같으며 멤버쉽 함수는 스케일된 삼각형 소속함수(triangle membership function)를 사용하였다.

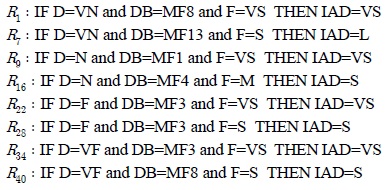

위의 표 1, 2, 3, 4를 바탕으로 피사체 거리, 깊이총량 및 카메라 초점거리에 대한 제어규칙은 55가지로 구성하였으며, 아래 피사체 거리별로 중요한 임의의 퍼지규칙 8개를 추출하여 아래와 같이 나열하였다.

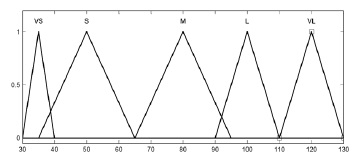

이와 같이 임의의 원거리 피사체를 피로감 없이 촬영 할 수 있는 카메라의 축간거리가 퍼지제어기로 추론 한 후, 이 카메라 축간거리 상에서 영상을 안정적으로 줌 할 수 있는 카메라의 최대 초점거리를 추론하는 퍼지제어기를 설계한다. 입력변수들은 그림 5의 (a)의 변수 D의 소속함수와 (d)의 변수 IAD의 소속함수를 사용하고, 카메라의 최대 초점거리에 대한 출력변수 F는 그림 6과 같이 5단계(VS, S, M, L, VL)로 분류한다.

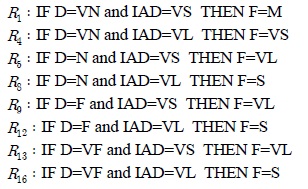

원거리 피사체에 대하여 안정된 화각범위를 취할 수 있는 카메라의 최대 초점거리를 결정하기 위하여 표 1, 2, 3, 4를 바탕으로 피사체 거리 D와 카메라 IAD에 대한 몇 가지 제어규칙을 다음과 같이 구성한다.

퍼지집합으로부터 하나의 출력값을 결정하는 비퍼지화 방법으로 각각의 퍼지 출력의 평균을 계산하는 무게중심법(center of gravity)을 사용하였다.

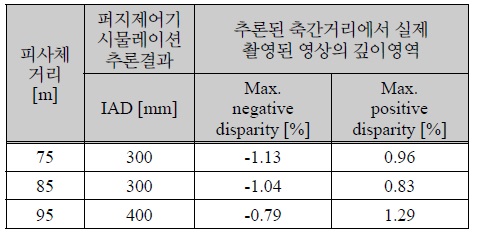

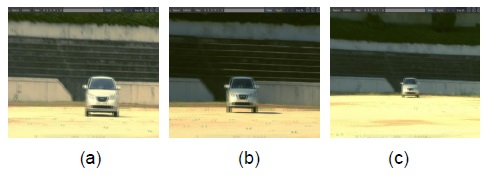

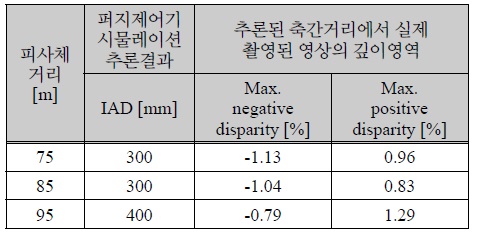

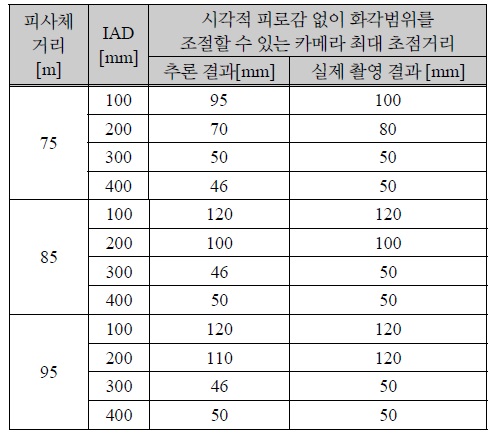

이들 입력변수들과 출력변수들 및 제어규칙을 활용하여 70[m], 80[m], 90[m], 100[m] 원거리 조건에서의 실험데이터를 바탕으로 퍼지제어기를 설계하였다. 이렇게 설계된 제어기를 통하여 임의의 75[m], 85[m], 95[m] 원거리 피사체들에 대하여 시각적인 피로감 없이 입체영상을 구현할 수 있는 영상을 획득할 수 있는 카메라의 축간거리는 300[mm]를 표 5와 같이 추론하였다. 여기서 카메라의 초점거리는 35[mm]로 두었고, 안정 입체영상을 위한 깊이총량을 2.08[%]로 두었다. 이들 값을 기준으로 실제 촬영된 그림 7의 영상을 분석한 결과 표 5와 같이 안정된 깊이영역에 들어옴을 확인할 수 있었다. 또한, 추론된 축간거리를 통하여 촬영된 영상을 그림 7에 제시하였으며, 입체영상을 분석하여 깊이영역이 안정영역에 들어감을 표 5와 같은 결과를 통하여 확인할 수 있었다.

카메라 축간거리 추론 및 영상분석

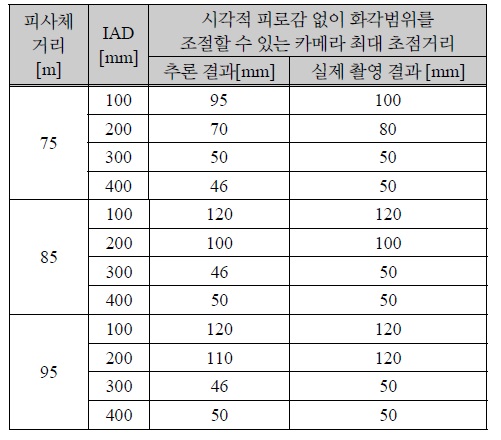

또한 75[m], 85[m], 95[m] 원거리 피사체들에 대하여 100[mm], 200[mm], 300[mm], 400[mm] 카메라의 축간 거리에서 시각적 피로감 없이 입체영상을 구현할 수 있는 카메라의 최대초점거리를 추론하였고, 실제 영상의 분석을 통하여 추론결과의 성능을 확인할 수 있었다.

카메라 최대 초점거리 비교

근거리 피사체는 일반적으로 두 카메라를 교차하여 주시점을 조절하여 좌우 영상을 획득하여 피사체의 입체감을 얻는다. 그러나 원거리 피사체인 경우 좌우 영상을 획득하여 합성하면 배경 영상의 시차가 과도하여 영상의 피로감이 커진다. 따라서 본 연구에서는 좌우 카메라를 수평으로 이동시키면서 원거리 피사체에 대하여 시각적 피로감 없이 입체영상을 획득 할 수 있는 카메라의 축간거리와 화각범위를 조절할 수 있는 카메라의 최대 초점거리를 결정하는 퍼지 제어기를 제안하였다. 레이더 센서로 피사체의 거리를 일정간격으로 측정하면서, 제작된 리그위에 있는 두 카메라를 수평으로 이동시켜 축간거리와 카메라 초점거리를 변화시키면서 좌우 영상을 획득하고 합성하여 분석하였다. 획득된 입체영상들에 대한 보정작업을 통하여 깊이총량이 피로감 없는 영상을 얻을 수 있는가를 판단하여, 안정된 영상을 획득하기 위한 카메라의 축간거리, 초점거리, 피사체 거리 및 깊이영역을 표로 만들었다. 이들 데이터를 근거로 피사체 거리, 깊이영역, 카메라 초점거리 및 카메라 축간거리 간의 퍼지관계를 수립하였다.

임의의 거리에 있는 원거리 피사체를 시각적 피로감 없이 입체영상을 획득할 수 있는 카메라의 축간거리와 그 축간거리에서 영상을 안정감 있게 화각 범위를 조절 할 수 있는 카메라의 최대 초점거리를 퍼지제어기로 추론하였다. 그리고 추론된 결과와 실영상을 획득하여 분석한 결과 퍼지제어기의 효용성을 확인하였다.

본 연구의 결과를 모듈로 제작하여 자동화 할 경우, 자연생태계 다큐멘터리나 축구나 야구 같은 스포츠 실시간 방송 등 입체촬영의 영역을 더 확대할 것으로 기대된다.

![70[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과](http://oak.go.kr/repository/journal/17467/HOJBC0_2015_v19n1_41_t001.jpg)

![80[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과](http://oak.go.kr/repository/journal/17467/HOJBC0_2015_v19n1_41_t002.jpg)

![90[m]에 있는 피사체에 대하여 축간거리와 카메라 초점 거리를 변화시키면서 획득한 입체영상의 분석결과](http://oak.go.kr/repository/journal/17467/HOJBC0_2015_v19n1_41_t003.jpg)

![100[m]에 있는 피사체에 대하여 축간거리와 카메라 초점거리를 변화시키면서 획득한 입체영상의 분석결과](http://oak.go.kr/repository/journal/17467/HOJBC0_2015_v19n1_41_t004.jpg)