EGML (effective Gaussian mixture learning) 기반 이동 객체 검출 (moving object detection; MOD) 알고리듬의 하드웨어 구현을 위한 설계조건을 분석하였다. EGML 알고리듬을 OpenCV 소프트웨어로 구현하고 다양한 영상들에 대한 시뮬레이션을 통해 배경학습 시간과 이동 객체 검출에 영향을 미치는 파라미터 조건을 분석하였다. 또한, 고정소수점 시뮬레이션을 통해 파라미터들의 비트 길이가 이동 객체 검출 성능에 미치는 영향을 평가하고, 최적 하드웨어 설계 조건을 도출하였다. 본 논문의 파라미터 비트 길이를 적용한 고정소수점 이동 객체 검출 모델은 부동소수점 연산 대비 약 절반의 비트 길이를 사용하면서 MOD 성능의 차이는 0.5% 이하이다.

An analysis of hardware design conditions of moving object detection (MOD) algorithm is described, which is based on effective Gaussian mixture learning (EGML). A simulation model of EGML algorithm is implemented using OpenCV, and the effects of some parameter values on background learning time and MOD sensitivity are analyzed for various images. In addition, optimal design conditions for hardware implementation of EGML-based MOD algorithm are extracted from fixed-point simulations for various bit-widths of parameters. The proposed fixed-point model of the EGML-based MOD uses only half of the bit-width at the expense of the loss of MOD performance within 0.5% when compared with floating-point MOD results.

감시시스템 (surveillance system)은 방범과 각종 사고 예방을 위해 도로, 교통, 건물 내ㆍ외부, 무인시설 등에서 널리 사용되고 있다. 최근에는 움직이는 객체가 검출된 경우만 영상을 저장하거나 움직이는 객체를 추적하는 지능형 감시시스템에 대한 관심이 높아지고 있으며, 이에 대한 연구가 활발히 이루어지고 있다[1,2]. 지능형 감시시스템의 기반을 이루는 기술 중 하나가 영상 속에서 움직이는 객체를 찾아내는 이동 객체 검출(moving object detection; MOD)이다.

MOD를 위해 장면 차분 (temporal difference) 기법, 배경 차분 (background subtraction) 기법 등 다양한 방법들이 사용된다. 장면 차분 기법은 이전 픽셀과 현재 픽셀의 차를 이용하여 배경과 객체를 구분하는 방법이며, 역동적인 배경에서는 배경을 모두 객체로 인식하고, 반대로 느린 이동 객체는 객체의 윤곽만을 객체로 인식하는 단점이 있다. 배경 차분 기법은 배경을 모델링하여 배경과 이동 객체를 검출하는 방법으로서 가장 널리 사용 되고 있으며, 배경의 변화에 따라 적응적으로 배경을 모델링 하는 적응적 배경 차분 알고리듬이 대표적인 방법이다. 이를 위해 사용되는 가우시안 혼합모델(Gaussian mixture model; GMM)은 영상의 각 픽셀에 대해 여러 개의 가우시안 확률 분포를 적용하여 배경을 모델링 하는 방법이다[3]. 이 방법은 배경에 적응해 나가는 학습 속도에 따라 성능에 큰 차이를 보이는 단점이 있다.

GMM 기반 배경 모델링 방법이 갖는 문제점을 해결하기 위해 EGML (effective Gaussian mixture learning)알고리듬이 제안되었으며, 각 가우시안 분포에 맞게 학습 속도를 조정함으로써 MOD 정확도를 향상시킨다[4]. 그러나 역동적인 배경, 화면 흔들림, 조명 변화, 그림자 등의 상황에서 MOD 정확도가 다소 떨어지는 단점을 갖기도 한다[5]. 이러한 요인들에 의한 영향을 줄이기 위해서는 영상의 종류에 따라 학습 속도와 알고리듬 파라미터 값을 적절하게 조절해야 한다.

본 논문에서는 EGML 알고리듬을 openCV로 구현하고, IEEE CDW-2012 데이터 세트에 제시된 기준 영상들에 대한 시뮬레이션을 통해 알고리듬 파라미터 값과 비트 길이가 MOD 성능에 미치는 영향을 분석하고 최적 하드웨어 설계 조건을 도출하였다.

MOD를 위한 알고리듬들은 다양한 수학적 모델을 기반으로 한다. 입력 영상의 환경적인 특성을 고려할 때, 실내인 경우 배경이 고정되어있을 가능성이 높아 움직이는 모든 물체를 이동 객체로 인식해도 큰 문제가 되지 않는다. 그러나 실외 환경인 경우에는 바람에 흔들리는 나뭇가지나 물결 등 움직이는 물체자체가 배경이 될 수 있기 때문에 복잡한 환경에서도 이동 객체를 올바로 검출할 수 있는 기술이 필요하다. MOD를 위한 많은 기법들이 존재하지만 주로 차 영상, 배경 차분, 광류 흐름을 적용시킨다. 이들 3가지 기법 중에서 배경 차분은 복잡한 환경에서도 우수한 성능을 갖기 때문에 일반적으로 많이 적용된다[6]. 배경 차분은 코드북 모델[7], 적응적 가우시안 혼합 모델[3], 비모수적 커널 기법[8] 등의 알고리듬이 존재한다.

배경 차분 기법은 관심 영역이 포함되지 않은 추정 이미지 (배경 모델)와 관찰 이미지 (입력 영상)를 비교하는 절차에 의해 전경을 추출한다. 배경 차분 기법에서 배경 또는 조명의 변화, 화면 흔들림, 그림자 등의 원인으로 전경 영역을 완벽히 정의하는 것이 매우 어려운 일이다. 따라서 이러한 문제점들에 강인한 이상적인 전경 영역 검출을 위한 새로운 방법이 제안 되고 있다[5]. RGB 색 공간을 기반으로 외곽선 비율에 따라 이동 객체와 그림자를 판정하는 방법이 문헌[9]에 제시되었다. 이동 객체와 그림자의 특성이 3차원 RGB 색 공간에서 분석되며, 현재 이미지와 배경 모델의 픽셀 밝기 및 색도의 왜곡에 기초하여 객체와 그림자를 구분한다.

문헌[10]에서는 빠른 조명 변화 조건에서 색도 모델과 휘도 비율 모델을 통해 접근 하는 방법을 제시하였다. 이 방식의 주요 초점은 빠른 조명 변화에 의해 오검출된 전경 픽셀들을 제거하는 것이다. 초기에 움직이는 물체와 오검출된 전경 픽셀 후보들을 분리하기 위해 색도 차 모델을 사용하여 오검출 전경 픽셀 확률 분포를 결정한다. 문헌[11]에서는 그림자 제거와 조명 변화 조건에서의 이동 객체 검출 방법을 제시하고 있다. 영상의 그림자 픽셀들을 제거하기 위하여 정규화된 국부적 감도 (local intensity)에 의해 그림자 픽셀들이 대체된다. 노이즈와 산란된 그림자를 제거하기 위해 침식 연산이 사용되며 윤곽 강조 기법을 사용하며 이동 객체의 윤곽을 찾고, 얻어진 이동 객체의 빈 공간을 채운다.

배경 차분 기반 MOD 알고리듬에서 가장 먼저 처리되는 과정은 배경 추출이다. 추출된 배경과 입력 픽셀값의 차 (difference)를 구하고, 그 차이가 설정된 임계값 보다 큰 경우에는 해당 픽셀을 전경으로 검출하며, 임계값 보다 작은 경우에는 배경으로 분류한다. 장면 변화에 따라 추출된 배경값이 변화를 보이는 경우에 적응적 가우시안 혼합모델을 이용하면 더욱 효과적인 배경 모델링이 가능하다.

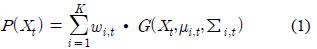

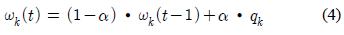

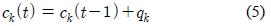

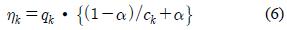

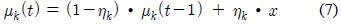

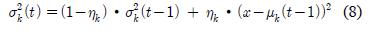

적응적 가우시안 혼합 모델에서 임의의 시간

가중치

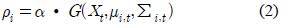

배경 차분 기반의 이동 객체 검출은 그림 1과 같이 크게 3단계의 과정으로 처리된다. 전처리 과정에서는 잡음 제거를 위해 가우시안 필터가 적용되며, 컬러 영상이 그레이 스케일로 변환된다. 전처리 과정 후, 배경 학습 알고리듬을 통해 배경이 학습되고, 입력 픽셀과 학습된 배경의 차를 분석하여 전경 또는 배경으로 분류된다. 후처리 과정에서는 MOD 결과를 보정하기 위해 메디안 필터가 적용된다.

EGML 알고리듬은 가변 학습율을 적용하여 가우시안의 평균

가우시안의 평균

입력되는 픽셀 값이 어느 가우시안에도 포함되지 않을 경우에는 식 (9)에 의해 가장 낮은 가중치를 갖는 가우시안의 파라미터들이 초기화된다. 새롭게 생성되는 가우시안은

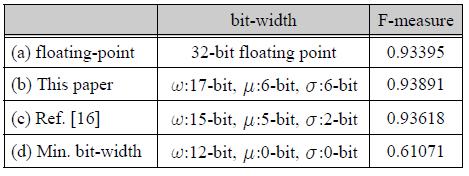

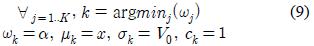

그림 2는 EGML을 포함한 대표적인 MOD 알고리듬 4가지의 MOD 결과를 보인 것이며, 표 1은 알고리듬 별 MOD 성능을 비교한 것이다[4,13-15]. F-measure는 검지율

MOD 알고리듬의 성능 비교

EGML 기반의 MOD 알고리듬을 C++ 및 OpenCV을 사용하여 모델링하였으며, IEEE CDW-2012 데이터 세트에 대한 MOD 결과를 ROC-Curve와 F-measure 값으로 MOD 성능을 분석하였다.

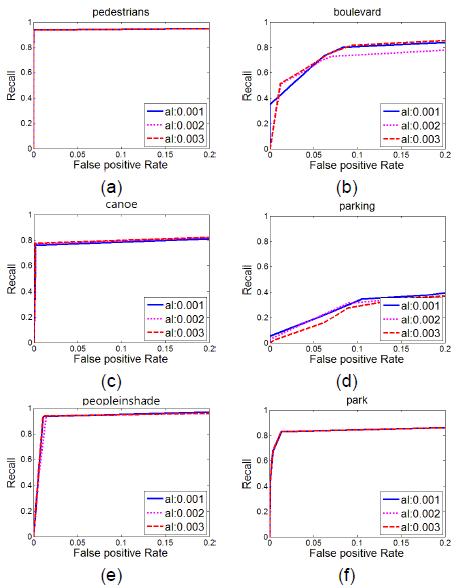

각 범주별 영상에 대한 분석 결과는 그림 3과 같으며, 대부분의 영상에서 ROC- Curve는 기울기가 1인 기준선 보다 상단에 형성되어 있어 EGML 알고리듬의 유용성을 확인할 수 있다. 알고리듬에 적용시킬 학습율

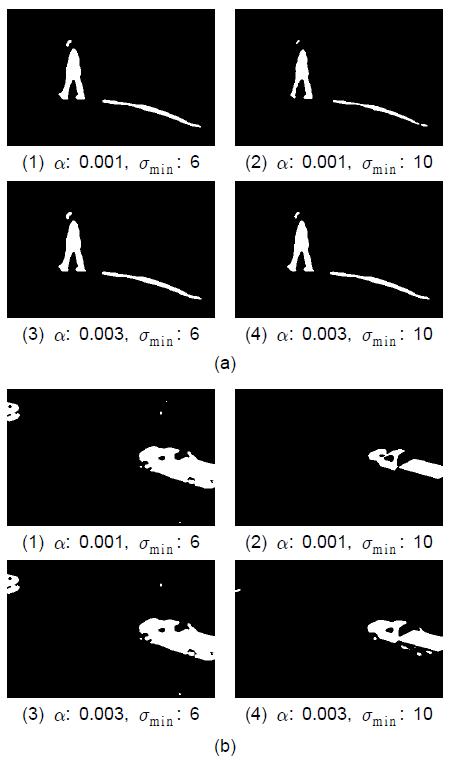

그림 4는 안정된 pedestrians 영상과 흔들림이 있는 불안정한 boulevard 영상에 대해

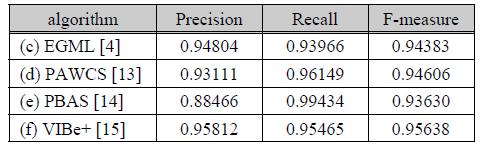

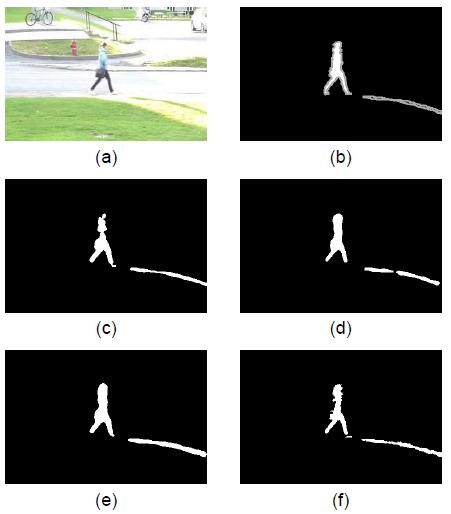

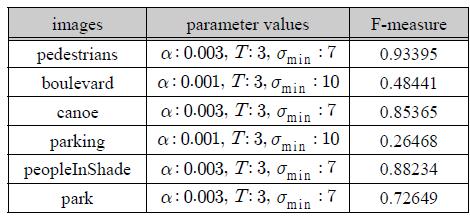

[표 2.] 파라미터에 따른 F-measure 성능 분석

파라미터에 따른 F-measure 성능 분석

EGML 기반 이동 객체 검출 시스템의 하드웨어 구현을 위해서는 고정소수점 (fixed-point) 연산이 적용되므로, 파라미터 및 연산 회로의 비트 길이가 MOD 결과에 미치는 영향을 고려해야 한다. EGML 기반 이동 객체 검출 알고리듬의 최적 하드웨어 설계조건을 도출하기 위해 고정소수점 시뮬레이션으로 성능을 분석하였다.

본 논문에서는 학습율

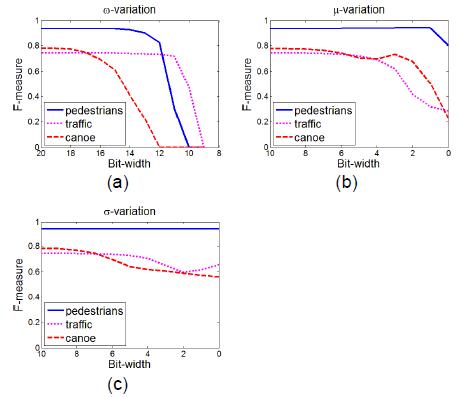

그림 5는 각각

또한 안정된 배경을 갖는 영상은 불안정한 영상에 비해

본 논문에서는 그림 6에서 F-measure가 급격히 감소하는 지점을 기준으로 해당 비트 길이에 약 2-비트의 마진을 적용해 최적의 비트 길이를

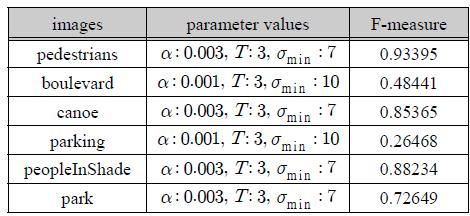

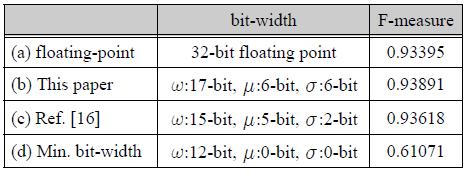

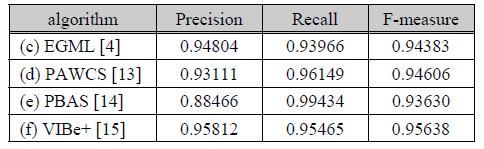

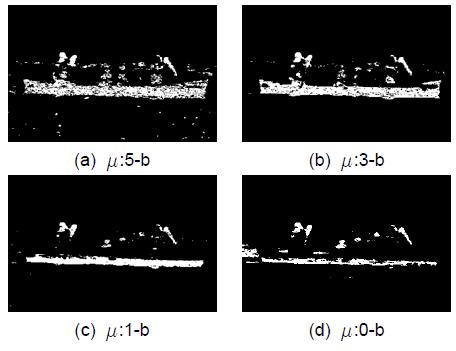

그림 7은 32-비트 부동소수점 (a), 본 논문에서 사용된 비트 길이 (b), 문헌[16]에서 적용된 비트 길이 (c) 그리고 MOD가 가능한 최소 비트 길이 (d)에 따른 MOD 결과를 보이고 있다. 표 3은 각각의 비트 길이에 따른 이동 객체 검출 결과의 F-measure값으로, 본 논문에서 결정된 비트 길이 (b)의 경우 부동소수점 연산 (a) 및 문헌[16]에서의 비트 길이 (c)에 비해 성능이 향상된 결과 를 보이고 있다.

비트 길이에 따른 F-measure 값

본 논문에서는 EGML 알고리듬을 이용한 이동 객체 검출 과정을 소프트웨어로 모델링 하였으며, 다른 MOD 알고리듬과의 F-measure 성능을 비교함으로써 해당 알고리듬의 유용성을 확인하였다, 또한 다양한 범주의 영상들에 대해 높은 MOD 성능을 갖도록 최적의 파라미터 값을 도출하였다. 또한, 하드웨어 설계를 위한 파라미터의 고정소수점 비트 길이를 분석하고 최적의 비트 길이를 도출하였다. 본 논문에서 결정된 고정 소수점 비트 길이는 부동소수점 연산 대비 약 절반의 비트 길이를 사용하면서 0.5% 이내의 MOD 성능 차이를 갖는 것으로 확인되었다.

![비트 길이에 따른 이동 객체 검출 결과 (a) 32-b 부동 소수점, (b) 고정 소수점 [본 논문], (c) 고정 소수점 [16], (d) 고정 소수점 [최소]](http://oak.go.kr/repository/journal/17156/HOJBC0_2015_v19n9_2153_f007.jpg)