The development of information technology (IT) has led to changes in medical education. IT has been used for e-learning and e-teaching, e-assessment, e-logistics, and e-administration. Pusan National University School of Medicine has developed its own educational information system using IT to support students’ learning and assessment and to manage curricular activities. Based on our experience, we propose six suggestions for designing new software, specifically regarding simplifying the design for users, communication with the programmer, a rapid cycle from design to implementation, orientation support for users, backup and security support, and obtaining patents. Collaborating with the Department of Medical Informatics within the School of Medicine has advantages, and an alliance among medical schools can simplify the development of software. In any case, curricular innovation should precede the introduction of technology because all technologies should support curricular goals.

인터넷과 같은 정보통신기술의 발달은 교육에 많은 변화를 가져왔다. 테크놀로지(technology)를 이용하여 학습을 지원하는 것을 통칭하는 이러닝(e-learning)은 시간과 장소에 구애받지 않는 상호작용(interaction)을 특징으로 하는데, 학생들에게 접근성과 편리성을 높여 학생 중심의 교육이 가능하게 하며 풍부한 학습자원을 제공할 수 있는 장점이 있다(Lee, 2007). 교육과정 또는 수업의 설계자는 기존의 면대면(face-to-face) 수업설계와 동시에 테크놀로지 사용을 고려하여야 하며, 이를 위해서 학생과 교수는 정보기술을 효과적으로 사용할 수 있어야 한다(Ellaway et al., 2008).

테크놀로지는 학생들의 학습을 위한 목적(e-learning and e-teaching) 이외에도, 학생평가를 위한 기능(e-assessment), 교육과정 운영과 행정을 위한 기능(e-logistics and e-administration), 공유와 참여를 위한 기능(e-community support)을 위해 사용될 수 있다. 우선, 학생평가는 지필시험과 같은 컴퓨터기반평가(computer-based test)를 비롯하여, 실기시험과 같은 수행기반평가(performace-based assessment), 포트폴리오를 포함하는 직무기반평가(practice-based assessment) 및 동료평가와 같은 행동/태도기반평가(behavior/attitude-based assessment)를 포함한다. 다음으로, 테크놀로지는 학생들의 학습을 위해 시간표, 일정 또는 학습추적과 같이 교육과정 운영과 행정을 위해 지원할 수 있으며, 블로그, 위키로 대표되는 웹 2.0 기술을 통하여 공유, 참여, 소통하면서 지식을 창출하는 집단의 기능을 지원할 수 있다(Ellaway & Masters, 2008).

교육과정을 설계·운영할 때, 학생들의 학습, 학생과 교육과정의 평가, 학사 운영 및 구성원의 참여를 위해 테크놀로지의 기능을 활용할 수 있다. 교육과정은 학습성과, 학습내용, 학생평가, 시간표 및 참고문헌 등의 아주 복잡한 구성요소가 서로 얽혀 있고, 학교는 이러한 구성요소의 정보를 효율적으로 관리할 필요가 있다. 즉, 교육과정의 각 구성요소들의 관계를 규명하여 ‘교육과정 지도(curriculum mapping)’를 그릴 수 있다면, 학생과 교수는 자신의 역할을 쉽게 인지하고 교육 담당자는 효과적으로 교육과정을 운영할 수 있을 것이다(Harden, 2001). 교육과정 지도를 그릴 때 정보기술의 지원은 필수적이다.

테크놀로지를 활용하기 위해서는 컴퓨터와 같은 하드웨어, 운영을 위한 프로그램과 도구를 포함하는 소프트웨어, 네트워크 연결과 저장 공간과 같은 기반시설이 필수적이다(Masters & Ellaway, 2008). 이러닝의 중요성을 인지하면서 각 대학에서 하드웨어와 기반 시설에 예산을 투자하지만 의학교육을 지원하는 소프트웨어를 확보하지 못해 운영이 미흡한 경우가 있다. 소프트웨어는 상품화된 프로그램을 구입하거나, 공개되어 있는 소스(open-source)를 이용 하거나, 직접 개발하여 사용할 수 있다. 프로그램을 구입하는 것은 저장이 용이하고 업체의 지원을 받을 수 있지만 학교에 맞게 수정하여 사용 하기가 어렵고 비용이 비싼 단점이 있다. 공개되어 있는 소스를 사용하는 것은 비용이 들지 않고 프로그램 상품을 구입하는 것보다 수정이 용이하나 공식적인 지원을 받기가 어렵고 시스템 변화에 대처하지 못한다. 학교에서 프로그램을 직접 개발하여 사용하는 경우 학교의 교육과정에 맞추어 지속적으로 수정할 수 있는 장점이 있다(Ellaway & Masters, 2008).

부산대학교 의학전문대학원에서는 2006년 이후 소프트웨어 개발자가 의학전문대학원 의학교육실에 근무함으로써 의학교육에 필요한 프로그램을 지속적으로 개발하였다. 본 논문에서는 부산대학교 의학전문대학원에서 개발한 프로그램들의 종류와 특징을 소개하고, 향후 프로그램 개발에 대하여 제언하고자 한다.

부산대학교 의학전문대학원에서 현재 사용하고 있는 프로그램은 컴퓨터기반평가, 실기시험평가, 임상실습평가, 수업지원시스템 및 강의평가시스템이며, 최근에 학습성과관리시스템을 완성하였다. 이들 프로그램을 개발한 목적, 기능, 개발과정을 간략하게 소개하고, 기능을 중심으로 프로그램의 특징들을 살펴보며, 향후 계획하고 있는 프로그램의 개발 방향을 기술하였다. 이러한 경험을 바탕으로 소프트웨어 개발에 대한 의견을 제시하고자 한다.

1) 컴퓨터기반평가

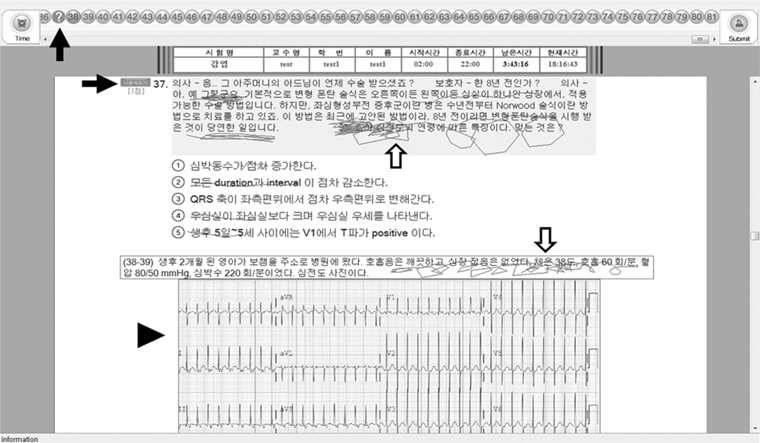

컴퓨터기반평가는 기존의 종이시험에 비해 편리하고 비용 면에서 유리하며 빠른 성적처리와 피드백을 위해 개발되었다. 시험 출제자는 일정한 양식에 따라 HWP 또는 DOC문서로 문항을 작성하여 업로드 하면 시험화면이 생성된다. 시험화면의 상단에는 시험 진행현황을 보여주는 문항번호가 있다. 상단의 문항번호는 시험문제를 풀면 색깔이 변하고, ‘나중에 보기’를 클릭하면 물음표로 바뀌므로 학생이 스스로 시험 진행을 조절할 수 있다. 학생은 종이시험과 같이 화면에 줄을 긋고 메모를 할 수 있으며, 그림이나 동영상 파일을 크게 확대하여 볼 수 있다(Figure 1). 시험이 종료되면 관리자는 학생들의 성적자료와 문항분석 자료를 다운로드받을 수 있다. 학생들은 자신의 시험결과를 확인할 수 있을 뿐 아니라, 정답이 포함되어 있는 문제를 다운로드받아 틀린 문제를 교정할 수 있고 시험 3일 후에 예정되어 있는 시험문제풀이 수업에서 문제에 대해 질의할 수 있다. 컴퓨터기반평가는 2007년도에 노트북 기반으로 준비하였으나 오류가 발생하여, 2009년도에 멀티미디어실 하드웨어를 구축하고, 2010년도부터 본격적으로 시행하여 현재 시험의 약 80%는 컴퓨터기반평가로 시행 하고 있다. 2012년도부터 기본의학교육평가 컨소시엄의 문제은행시스템과 연결하여 문항관리를 시행하고 있고, 멀티미디어 자료를 활용한 평가문항에 대비하여 프로그램을 보완하고 있다.

2) 실기시험평가시스템

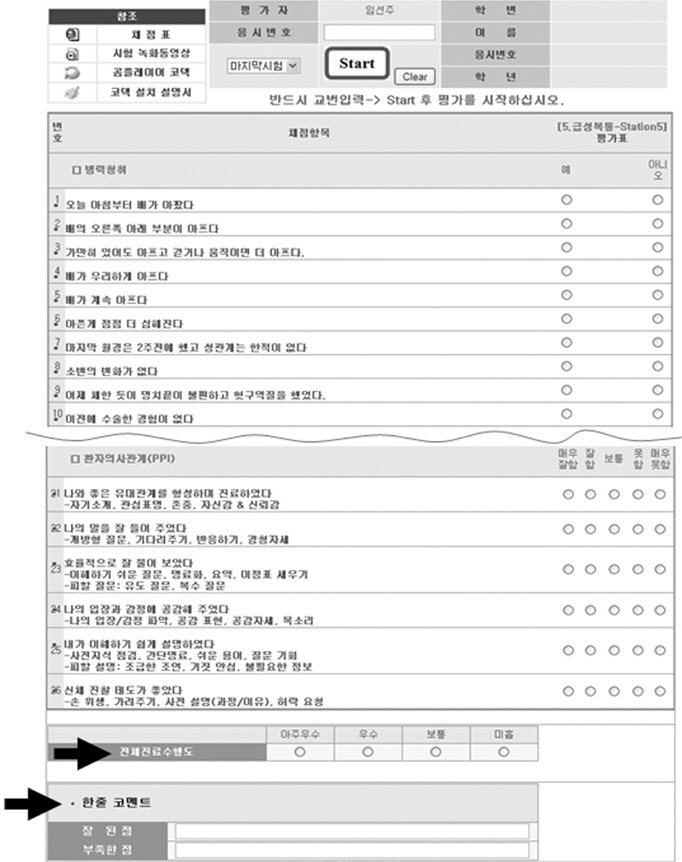

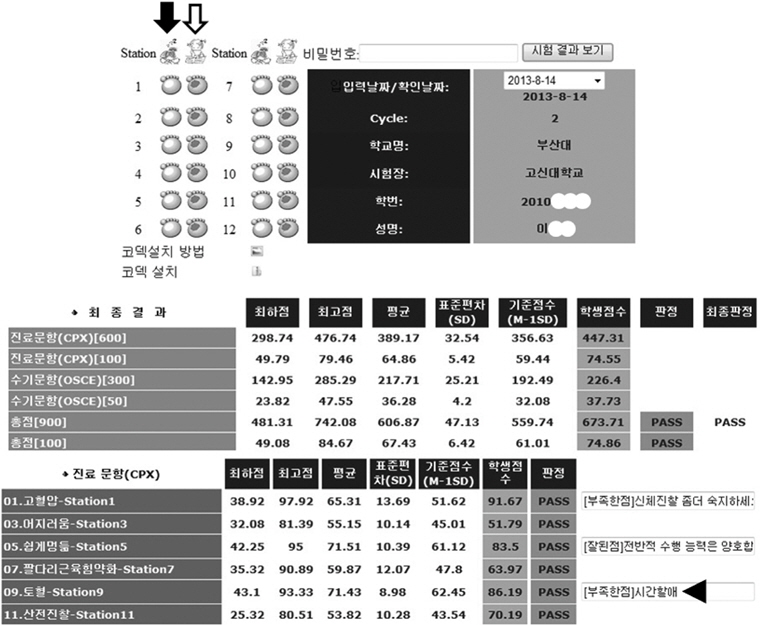

실기시험평가시스템은 실기채점과 성적처리를 효율적으로 시행하고, 학생들에게 수행에 대해 개별적으로 피드백을 제공하기 위해 개발되었다. 문항을 업로드하면 채점자가 채점할 수 있는 화면이 생성된다. 컴퓨터 화면의 채점표는 문항에 있는 병력청취, 신체진찰, 환자교육 및 환자․ 의사관계 체크리스트와 전체진료수행도, 한 줄 코멘트로 구성이 되어 있다(Figure 2). 학생순환 일정표를 등록해 놓으면 학생순환에 따라 동영상이 스테이션별, 학생별로 자동적으로 분리되어 녹화시스템에 저장된다. 시험 종료 후 관리자는 항목별, 영역별로 자동 처리된 성적 데이터를 볼 수 있다. 학생들은 시험이 마친 직후 홈페이지에 접속하여 자신의 결과와 코멘트를 확인할 수 있으며, 최고점을 받은 학생의 동영상과 자신의 수행 동영상을 함께 볼 수 있다(Figure 3). 2009년도에 채점시스템을 개발하여 적용 하였고, 이후 녹화시스템 연결(2011), 컴퓨터기반사이시험(2012)을 추가하였으며, 2013년도에 타 대학의 원격지원을 성공하였다.

3) 임상실습평가시스템

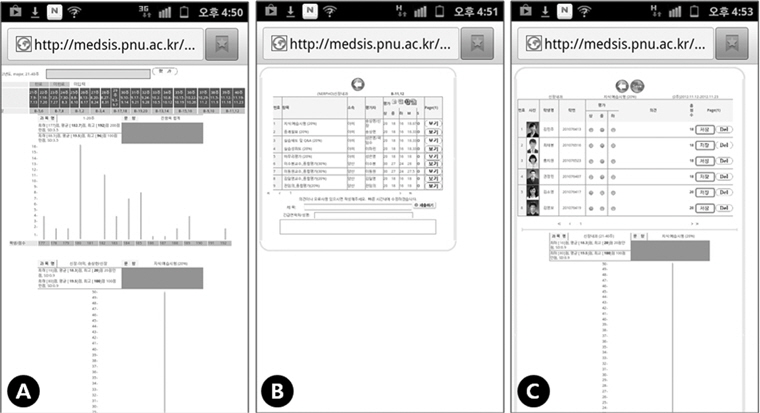

임상실습평가시스템은 임상실습 성적의 신뢰성을 확보하고 학생에게 즉각적으로 피드백을 제공하기 위해 개발되었다. 각 임상과에서 제시한 평가항목과 평가척도에 따라 채점할 수 있는 화면을 구성 하였다. 임상교수는 자신이 담당한 실습항목의 성적분포그래프를 확인하면서 학생들의 점수를 입력하고, 최하점을 입력한 경우 의견을 기록한다(Figure 4). 임상교수는 실습지도 중에 스마트폰을 사용하여 입력할 수 있으며, 조별로 실습 종료 2주 이내에 성적을 입력하여야 한다. 임상실습 담당자는 관리자 화면에서 각 과별 입력현황과 전체 점수결과를 확인할 수 있다. 학생들은 특정 임상과의 실습을 마치면 홈페이지에 접속하여 실습평가를 시행한 후 성적분포그래프와 함께 자신의 실습결과를 확인할 수 있고, 이의가 있을 시 실습책임교수에게 성적확인요청서를 제출할 수 있다. 실습지원시스템은 2008년도에 실기시험항목에 대한 실습을 추적관찰하기 위해 개발 되었으나 운영이 복잡하여 2011년도에 폐지하였다. 이후 실습평가는 예진, 환자보고, 토론과 같이 실습활동 중에 평가하는 직무중심평가(workplace-based assessment)로 전환하였고(Norcini & Burch, 2007), 2012년부터 임상실습평가시스템을 사용하고 있다.

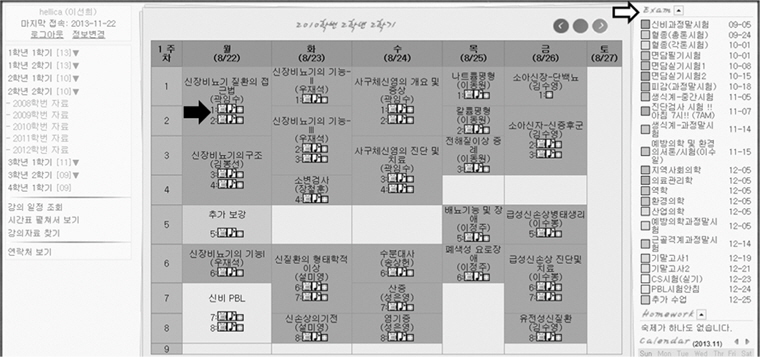

4) 수업지원시스템

수업지원시스템은 통합교육의 학사일정을 원활하게 관리하고, 학생들의 개별학습을 지원하기 위해 개발하였다. 과정(course)의 수업명, 교수, 수업시간을 입력하면, 주별 시간표 화면이 구성된다. 강의실에 설치된 녹화시스템을 통하여 50분 단위의 수업을 음성 또는 녹화파일이 자동적으로 시간표화면에 업로드 된다. 학생들은 시간표 화면에서 강의록, 음성, 녹화파일을 다운로드받아 수업시간에 놓친 부분을 확인할 수 있고, 시험일정에 따른 범위, 교수별 수업등을 검색할 수 있다(Figure 5). U-class 출석시스템과 연동되어 출석 및 퀴즈결과를 실시간 확인할 수 있다. 2007년도에 의학전문대학원 학생이 자발적으로 설계하여 기부하였으며, 수업 담당교수에게 동영상 녹화에 대한 동의를 구한 후 2008년부터 사용하였고, 2010년도에 U-class시스템과 연결하였다.

5) 강의평가시스템

강의평가시스템은 블록식의 통합교육에서 효율적으로 강의평가를 시행하기 위해 개발하였다. 학기 종료 후 교수 1인에 대해 시행하는 타 단과대학의 강의평가방법을 의학교육에 적용하기 어렵다. 엑셀파일로 저장된 교수․ 과정(course)의 강의평가 일정을 업로드하면, 지정한 강의평가 시작일로부터 7일간 자동적으로 강의평가 화면이 생성된다. 담당자는 교수별, 과정별로 강의평가결과를 다운로드 받아 과정 책임교수에게 전달한다. 2008년도에 처음으로 개발하여 적용하였으며, 수업지원시스템과 연동 계획이다.

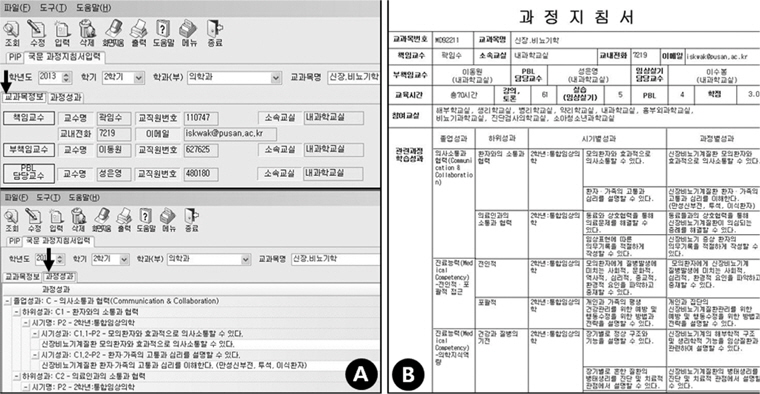

6) 과정지침서 & 학습성과관리시스템

과정지침서와 학습성과관리시스템은 학습성과의 연계를 관리하고 과정과 수업을 관리하기 위해 개발하였다. 졸업성과(exit outcome)와 시기성과(phase outcome)는 코드별로 구분되어 저장이 되어 있으며, 과정 책임교수는 과정지침서를 작성할 때 시기성과에 따라 과정성과(course outcome)를 입력하고, 과정에 포함되어 있는 문제바탕학습(problem-based learning), 임상실기(clinical skills) 및 실습 등의 계획과, 시간표 구성을 입력한다(Figure 6). 각 수업 담당교수는 과정성과에 따라 자신이 맡은 강의의 수업성과(lesson outcome)를 입력하는데, 임상표현(clinical presentation)에 따른 수업성과 코드를 함께 입력하도록 하였다. 학습성과위원회는 학습성과별, 임상표현별로 수업의 현황을 검색할 수 있고, 문제바탕학습, 임상실기, 형성평가, 인문학 연계수업도 검색할 수 있다. 2011년도 부터 부산대학교 본교 정보전산원 팀과 협력하여 2013년에 완성하였다.

1) 의학전문대학원에서 자체적으로 개발한 소프트웨어

소프트웨어는 대부분 의학전문대학원 자체에서 개발하였다. 컴퓨터기반시험, 실기시험채점시스템, 임상실습평가시스템, 수업지원시스템 및 강의평가시스템은 의학전문대학원 자체에서 개발하여 사용하였고, 학습성과시스템은 부산대학교 본교 정보전산원의 기술적 지원을 받아 의학전문대학원과 함께 개발하였다. 따라서 의학전문대학원 교육과정에 맞추어 프로그램을 설계할 수 있었으며, 지속적으로 프로그램을 개선할 수 있었다. 프로그램 개발자는 교육과정 설계자 또는 운영자로부터 최초 아이디어를 제시받아 프로그램을 단독으로 설계하였기 때문에 기술적 또는 디자인 면에서 미흡하며, 학교는 프로그램 개발자에 대한 의존도가 심한 단점이 있다(Ellaway & Masters, 2008).

2) 평가(e-assessment)와 행정(e-logistics and e-administration) 기능 중심

프로그램의 개발 목적은 우선, 평가를 위한 복잡한 과정들을 편리하게 하고 학생에게 신속하게 피드백을 시행하기 위한 것이었다. 기존의 종이로 시행하는 시험(paper-based test)에 비해 컴퓨터기반 시험은 즉각적인 피드백과 멀티미디어 자료제공이 가능하며 시간과 장소의 제한이 없고 문항의 질적 관리가 용이한 장점이 있다(Im et al., 2008). 부산대학교 의학전문대학원은 컴퓨터기반시험을 통해 학생과 교수에게 피드백을 신속하게 제공할 수 있었으며, 해외실습 중인 학생에게 원격으로 시험을 진행하여 학사일정에 차질 없이 학생이 실습을 진행할 수 있었다.

실기시험채점시스템은 실기시험결과의 복잡한 통계를 자동적으로 처리하며 자신의 동영상과 최고 득점한 학생의 동영상을 볼 수 있도록 설계하였다. 학생들은 시험 종료 후 바로 자신의 수행결과를 파악할 수 있으며, 수행을 아주 잘한 학생들의 동영상을 통하여 자신의 수행의 구체적인 부분에 대해 문제점을 파악하고 성찰할 수 있다. White et al. (2009)이 실기시험 후에 온라인 시스템을 통해 학생들의 수행에 대해 자기평가(self-assessment), 성찰 및 피드백의 기회를 제공한 것과 유사하다.

임상실습평가시스템은 학생들에게 실습성적을 피드백하고, 교육 과정 실행을 모니터링하기 위한 것이었다. 임상실습은 임상교수가 학생들이 순환함에 따라 즉각적으로 성적을 입력할 수 있도록 하였으며, 학생들은 특정 임상과의 실습을 마치고 나면 실습에 대한 설문지를 작성한 후 성적을 확인할 수 있었다. 또, 임상교수는 자신의 채점한 실습성적을 그래프로 보면서 모니터링하고, 의학교육실에서는 실습 전체를 관리할 수 있다.

강의평가시스템과 학습성과시스템은 교육과정에 대해 문제점을 개선하고자 설계한 것이다. 현재 우리나라의 의학교육과정은 장기 기반 통합(organ-based integration)으로 여러 교수가 함께 수업하며, 2-4주 간격으로 한 과정(course)이 끝나고 다른 과정이 시작되는 블록식(block)으로 수업이 이루어지고 있다. 따라서 다른 단과대학의 강의평가는 대부분 학기 종료 시 교수 1인에 대한 평가를 하는데 반하여, 의학교육은 블록이 마친 직후 과정의 구성에 대한 평가와 수업 참여교수에 대한 평가가 동시에 이루어져야 한다.

3) 교육과정 지도 지향

수업지원시스템은 학생들에게 강의록을 제공하고 수업의 오디오 또는 비디오 자료를 제공하지만, 다른 대부분의 의학교육정보시스템은 ‘내용(content)’을 포함하지 않는다. 또, 온라인환경에서 언제 어디서나 토론을 하고, 시험을 칠 수 있는 ‘과정(process)’ 중심의 시스템도 부족하다

부산대학교 의학전문대학원의 시스템은 교육내용을 모으고(과정지침서와 학습성과시스템), 학생들의 평가결과를 축적하며(컴퓨터기반시험, 실기시험채점시스템 및 임상실습평가시스템), 교육에 관여한 교수들의 정보를 얻어(모든 시스템), ‘교육과정 지도’를 구축 함으로써, 교육과정을 관리·개선하기 위해 지속적으로 데이터를 확보하고, 학생들의 배움을 추적·관리할 수 있는 통합시스템을 지향 하고 있다(Goldfarb & Morrison, 2014; Harden, 2001).

교육과정 지도는 학습성과, 교육내용, 학생평가, 학습의 기회, 강의장소, 학습자료, 시간표, 강의자, 교육과정 운영 및 학생에 대한 자료를 포함하며, 학생, 교수 또는 교육과정 개발자 및 운영자에게 교육과정에 대하여 투명하게 보여주고, 교육과정요소들의 관계를 규명하는 기능을 한다. 학생, 교수 또는 교육과정 개발자는 필요한 정보가 서로 다르기 때문에 요구분석(needs assessments)을 통하여 축적한 데이터들을 효과적으로 제시할 필요가 있다. 교육과정 지도를 파악할 때 테크놀로지의 사용은 교육과정의 복잡한 요소들의 관계를 효율적으로 제공하고, 사용자에게 필요한 정보를 맞춤형으로 제공할 것이다(Harden, 2001).

1) 포트폴리오

포트폴리오(e-portfolio)는 성과중심교육이 도입되면서 중요시 되고 있다(Friedman Ben David et al., 2001). 포트폴리오 시스템은 학부과정에서 학생들에게 학습성과 달성에 대한 정보를 제공함으로써 학생 스스로가 부족한 역량을 달성할 수 있도록 하고, 졸업 후에도 학생들의 진로를 추적·관리할 수 있는 종합정보시스템이다. 학습성과 도달 여부를 판단하는 근거들 즉, 각 교과목의 평가자료, 임상실습수행과 평가자료, 실기시험과 필기시험을 포함한 종합시험결과 등을 종합하여, 학생들의 수준을 연속적으로 또는 학습성과별로 보여 주는 시스템을 계획하고 있다.

2) 협력도구를 포함하는 학습지원시스템

지식정보화사회는 지식을 이해하고 적용하는 것보다 서로 협력 하여 지식을 창출하는 것을 요구한다. 임상실습의 경우, 한 해 동안 여러 조의 학생들이 실습하며, 이러한 실습이 매년 시행됨에도 불구하고 학습자료의 축적은 미비하다. 학생들이 실습을 순환함에 따라 지속적으로 학습자료를 축적할 수 있는 위키(wiki) 기반의 학습지원 시스템(learning management system)의 도입을 준비 중에 있다.

3) 모바일 중심

스마트폰의 활용이 높아짐에 따라 의학교육지원시스템은 스마트폰상에서 사용하기 쉬워야 한다. 임상교수들은 학생들의 실습을 관찰하면서 즉시 평가결과를 입력할 수 있고, 학생들은 스마트폰으로 자신의 결과를 확인할 수 있어야 한다. 스마트폰 환경에서 학생과 교수의 소통이 원활하도록 구현할 계획이다.

4) 프로그램의 통합

의학전문대학원 자체의 프로그램들을 통합하고, 의학전문대학원과 부산대학교 본교의 프로그램을 연동할 예정이다. 학습성과시스템, 수업지원시스템, 강의평가 및 각종 평가시스템은 필요성에 따라 각각 구축되었지만 서로 연동되어 있어야 하며, 의학전문대학원과 본교의 데이터 교류에 대해 논의 중에 있다.

컴퓨터와 같은 하드웨어를 포함하는 기반시설은 예산 투자가 집중적으로 이루어지는 부분이나, 하드웨어 구축만으로 의학교육정보 시스템을 원활하게 운영하기는 어렵다. 교육과정을 지원하는 소프트웨어 구축 또한 매우 중요한데, 소프트웨어를 개발하는 경우 부산대학교 의학전문대학원의 경험을 바탕으로 의견을 제시하고자 한다.

첫째, 프로그램은 단순해야 한다. 프로그램이 복잡하거나 기능이 많으면 학생과 교수가 사용하기 어렵다. 임상실습평가시스템은 초기 2008년도에 포트폴리오 평가를 지원하였으나 프로그램이 복잡하여 실패하였다. 학생과 교수가 편리하게 사용할 수 있도록 쉽고 단순하게 설계하여야 하며, 특히 교수지원이 필요할 수 있다. 학습성과시스템은 연계성을 우선으로 하여 시스템을 설계하였기 때문에 다소 복잡하여, 워크숍을 통해 개발한 2013년도의 과정정보와 학습성과의 기본 데이터를 담당직원이 입력한 후, 담당교수는 ‘불러오기’ 기능을 통하여 수정하도록 하였다

둘째, 프로그램 개발자와 충분히 소통해야 하고, 개발자가 업무를 파악해야 좋은 프로그램을 개발할 수 있다. 프로그램 설계의 초기단계는 교육과정 운영자와 개발자가 아이디어에 대해 논의하는 형태로 이루어졌다. 아이디어를 스토리보드와 같은 설계화면으로 작성하면 소통이 원활하였다. 실기시험채점시스템은 개발자가 실기시험의 순환형태를 파악하고, 통계 처리과정을 이해한 후 프로그램으로 구현할 수 있었다.

셋째, 프로그램을 설계하여 적용한 후 문제점을 개선하기까지의 빠른 순환구조가 필요하다. 일반적으로 소프트웨어의 설계와 개발에 시간을 소요하고 완성한 후에 사용자가 접하게 되는데, 이때에는 사용자의 의견을 반영하기 어렵다. 따라서 핵심적인 기능들로만 구성하여 초기 단계의 프로그램을 실행해보고 사용자의 의견을 반영하여 수정할 수 있어야 한다. 이러한 래피드프로토타입(rapid prototype) 개발 방법론은, 설계 초기에 최종 프로그램의 핵심요소를 통합하여 실행 가능한 형태를 보여줌으로써, 사용자와 설계자가 협동하면서 참여하면서 프로그램을 지속적으로 수정할 수 있다(Tripp & Bichelmeyer, 1990). 또한 개발에 소요되는 시간을 단축하고, 사용자의 만족도가 높은 장점이 있다(Jones & Richey, 2000).

넷째, 프로그램을 사용하는 학생, 교수 및 직원에게 교육과 홍보가 필요하다. 프로그램을 처음 도입할 때 학생과 교수의 저항이 있을 수 있다. 사용자를 위한 교육을 여러 번 시행하고, 안내책자 등을 배포하여 홍보하는 것은 아주 중요하다. 특히 교육과정 관리 담당자는 해당 교육과정과 연계된 프로그램을 충분히 사용할 줄 알아야 하며, 교수와 학생들을 안내할 수 있어야 한다.

다섯째, 백업시스템과 보안 등의 문제를 해결해야 한다. 백업은 갑작스런 정전 등의 사태가 발생했을 때 다른 전력을 동원할 수 있고, 특정 서버에 문제가 생기는 경우 다른 서버에 동시에 저장이 되어야 한다. 또 전산시스템은 학교의 보안정책에 따라 엄격히 관리 되어야 한다. 컴퓨터기반시험의 경우, 마지막 10분 전에 시험문제를 업로드하며, 휴대폰을 포함한 전자기기 사용을 엄격히 제한하고, 문항순서를 섞고, 시험을 치르는 학생들의 모습을 녹화하는 등의 장치가 필요하였다.

여섯째, 특허신청이 필요할 수 있다. 상업적인 용도가 아니라 개발의 권리를 확보하기 위해 특허신청이 필요하다. 현재 부산대학교 의학전문대학원은 의학교육정보시스템과 관련하여 특허등록 5개, 출원 8개를 보유하고 있다.

부산대학교 의학전문대학원에서 자체 개발한 의학교육을 지원하는 소프트웨어와 그 특징을 살펴보고 의학교육정보시스템 구축에 대한 의견을 제시하였다. 부산대학교 의학전문대학원은 의학교육실내에 소프트웨어 개발교수가 상주하고 있으므로 교육과정과 연계한 프로그램을 개발하고 지속 발전할 수 있었다. 의학전문대학원은 다른 단과대학과 다른 교육과정을 운영하고 있어 본교의 학사일정이나 전산시스템을 사용하기 어렵다. 따라서 의학전문대학원 별도의 정보전산기구를 갖는 것이 유리할 수 있다.

의학교육정보시스템과 관련하여 의학전문대학원의 연합이 필요할 수 있다. 국가고시에 실기시험이 도입되었을 때 각 대학은 문항과 표준화 환자를 공유하고 정보를 교류하기 위해 지역의 컨소시엄에 가입하여 공동으로 준비하였다. 의학교육정보시스템 또한 하드웨어를 구축하더라도 소프트웨어 개발에 많은 예산이 필요하다. 각 대학이 연합한다면 프로그램을 개발에 대한 부담을 줄일 수 있을 것이다.

모든 테크놀로지는 교육과정 운영을 편리하게 하지만 교육과정의 중심이 되는 것이 아니라 교육과정을 지원하는 것이다. 교육과정개선이 선행되어야 하고 개선된 교육과정에 맞추어 테크놀로지의 사용을 고려할 수 있다.

테크놀로지의 발전은 급격하다. 데스크탑을 이용한 이러닝에서 테블릿 또는 스마트폰으로 환경으로 변하고 있다. 테크놀로지 환경을 구축하는 현재의 시점에 앞으로의 이러닝 환경의 변화를 준비하여야 할 것이다.