본 논문은 사용자의 입력, 색상 및 깊이 정보를 이용한 의미론적 물체 분할 방법을 제안한다. 의미있는 영역을 깊이영상에서 유사한 깊이 정보와 사용자 스트로크 입력의 중심에 위치한다고 가정한다. 제안된 방법은 스트로크 입력을 이용하여 관심 영역을 설정하고, 색상과 깊이 정보를 이용하여 의미있는 영역을 검출한다. 구체적으로 제안방법은 관심영역에 대해 색상과 깊이 정보를 이용한 과분할 과정과 과분할 영역에 대해 깊이 정보를 이용한 의미론적 물체 추출과정으로 구성되어 있다. 과분할 과정에서 적응적 임계값 적용 및 형태학적 기울기에 대한 적응적인 가중치 적용을 통한 마커 추출 방법을 제안하였다. 의미론적 물체 추출과정에서는 관심영역의 가장자리 영역에서 내부 영역으로의 순서대로 전체 깊이의 평균과 차이를 이용하여 추출하고자 하는 물체 영역인지 아닌지를 결정하도록 하였다. 실험 결과에서 제안한 방법이 효과적으로 의미있는 물체 추출 결과를 얻을 수 있음을 보인다.

This paper presents a semantic object extraction method using user's stroke input, color, and depth information. It is supposed that a semantically meaningful object is surrounded with a few strokes from a user, and has similar depths all over the object. In the proposed method, deciding the region of interest (ROI) is based on the stroke input, and the semantically meaningful object is extracted by using color and depth information. Specifically, the proposed method consists of two steps. The first step is over-segmentation inside the ROI using color and depth information. The second step is semantically meaningful object extraction where over-segmented regions are classified into the object region and the background region according to the depth of each region. In the over-segmentation step, we propose a new marker extraction method where there are two propositions, i.e. an adaptive thresholding scheme to maximize the number of the segmented regions and an adaptive weighting scheme for color and depth components in computation of the morphological gradients that is required in the marker extraction. In the semantically meaningful object extraction, we classify over-segmented regions into the object region and the background region in order of the boundary regions to the inner regions, the average depth of each region being compared to the average depth of all regions classified into the object region. In experimental results, we demonstrate that the proposed method yields reasonable object extraction results.

최근 고성능 카메라를 장착한 스마트폰과 태블릿 PC의 등장으로 인해 사용자들은 언제 어디서나 실시간으로 영상을 얻을 수 있고, 영상을 이용하여 실시간으로 처리 할 수 있는 기술을 요구한다. 사용자의 편의성을 도모하기 위하여 관심 영역에서 의미있는 물체를 자동으로 추출하여 다른 영상에 합성하거나 물체를 편집할 수 있는 기술 또한 요구되고 있다. 또한 스마트폰과 태블릿 PC는 사용자의 터치입력을 기반으로 하고 있기 때문에 의미있는 물체 추출에 사용자의 터치 입력이 활용될 수 있다. 물체를 추출하기 위해서 사용자의 터치 입력으로 물체에 대한 힌트를 입력 받고, 이를 이용하여 효과적으로 물체를 추출할 수 있는 기술이 필요하게 되었다.

본 논문에서 이루고자하는 의미있는 물체 추출이란 사용자가 의도하였던 물체 단위의 추출을 의미한다. 하나의 물체라고 할지라도 물체 내부에는 서로 다른 색상을 가지고 있으며, 이는 하나의 물체에 속하지만 서로 다른 영역으로 분할될 수 밖에 없다. 그러나 본 논문에서는 색상과 깊이정보 그리고 사용자 입력 정보를 이용하여 영역 단위가 아닌 물체 단위의 추출을 이루고자 한다. 물체 단위의 추출을 위해서는 영역분할이 수행되어야 하는데, 대표적인 방법으로는 임계값을 이용한 분할 기법[1], 경계 기반 분할 기법[2], 영역 기반 분할 기법[3], 영역 및 경계 기반의 분할 방법[4-8]이 있다.

본 논문에서는 사용자가 입력한 스트로크(stroke)를 통해 관심영역을 설정하고 영상의 색상 정보와 깊이 정보의 특성을 이용한 영상 분할을 통해 효과적으로 의미있는 물체를 추출할 수 있는 방법을 설계하였다. 의미있는 물체를 사용자 입력의 중심 부분을 포함한다는 점, 유사한 깊이정보를 가진다는 점, 관심영역에서 가장자리 부분은 배경일 가능성이 높다는 점을 이용하였다.

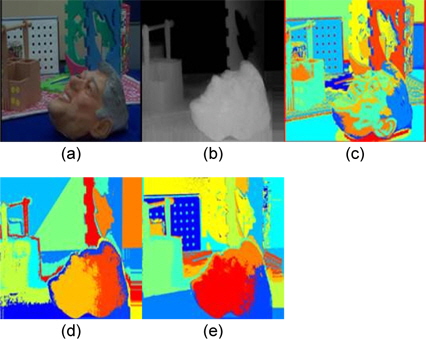

최근 스테레오(stereo) 카메라와 깊이 측정이 가능한 카메라가 출연함에 따라 색상과 물체의 깊이 정보를 동시에 이용하여 영상을 분할하는 방법이 활발히 연구되고 있다. Mutto는 그림1에서처럼 색상 정보를 CIELAB 색공간으로 변환하여 깊이정보와 함께 K-means 군집화 알고리즘을 사용하여 영상을 분할하는 방법을 제안하였다[11]. 또한 Bleiweiss는 RGB 색상정보와 깊이 정보를 이용한 영상 분할 방식을 제안하였다[12]. Bleiweiss가 제안한 방법은 XYRGBD로 6D vector로 구성 후 Mean Shift 분할 방식을 사용하여 영역을 분할하여 RGB 색상 모델을 사용한 경우보다 좋은 결과를 획득하였다.

최근 의미론적 영상 분할 방법은 다양하게 연구 진행되고 있다. 의미론적 영상 분할을 통하여 영상에서 각각에 의미있는 영역으로 분류하여 다양한 분야에 응용하여 사용할 수 있다. W. Zou가 제안한 방법은 region bank를 만들어 각각의 level에 따라 색상정보를 통해 분할한 영상을 이용하여 SVM(support vector machine)를 통해 영역을 분류하여 병합하는 방법을 제안하였다[9]. 또한 최근에는 STF(semantic texton forests)를 이용한 방법을 사용하여 트리(tree)를 구성하여 분할하는 방식이 연구되고 있다[10]. 하지만 이러한 방법들은 색상정보만을 이용한 분할방식은 다양한 색상정보를 포함한 단일 물체를 추출하기에는 부정확할 결과를 보인다.

분수령(watershed) 알고리즘은 지형학에서 연구된 것으로 지형도에서 공간적 경사도를 영상의 밝기 값 크기의 고도로 생각하고 영역을 분할하는 방법이다. 분수령 알고리즘은 경계, 영역 기반의 분할 방법으로 담금(immersion) 방식과 강우(rainfall) 방식으로 구분할 수 있다. 본 논문에서는 담금 방식을 사용하여 분수령 알고리즘 구현하였다. 담금 방식은 가장 낮은 고도부터 차례로 담수지역에 물을 채워가면서 다른 국부 최소치(local minima)에 이르면 두 영역에의 수면을 동시에 상승시켜 수면이 다른 담수지역에 넘칠 때까지 상승시킨다. 수면이 넘칠 때 가상의 댐을 건설하여 수면이 넘치는 것을 방지한다. 이 과정을 반복하여 가장 높은 고도가 될 때까지 진행된다. 국부 최소치를 중심으로 하나의 영역이 담수지역이 되고, 이 가상의 댐이 분수령이 된다. 영상의 밝기 값의 크기를 고도로 생각할 경우 담수 지역은 영상의 분할 영역되고 분수령은 경계선이 된다.

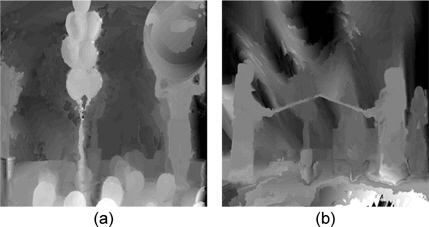

깊이영상(depth image)은 객체의 3차원 거리 정보를 이용하여 깊이를 화소 값으로 표현한 영상이다. 깊이영상은 깊이 카메라를 이용하여 획득하는 방법, 스테레오 카메라나 다중 카메라를 사용하여 얻은 다수의 영상을 이용하여 깊이를 획득하는 방법이 있다. 깊이 추정 참조 소프트웨어(Depth Estimation Reference Software : DERS)은 MPEG 3차원 비디오 부호화 그룹에서 3차원 비디오 부호화 기술의 국제 표준을 만들기 위해 깊이 추정 참조 소프트웨어를 개발하였다[13]. 깊이 추정 참조 소프트웨어는 다중 카메라를 통해 얻은 영상의 상관관계를 이용하여 깊이정보를 추출해주는 소프트웨어다. 이 기술은 일본 Nagoya 대학에 의해 제안되었고 윈도우 기반 초기 변이 추정 및 그래프 컷(graph cut) 기반의 전역 변이 추정 기법이 사용되었다. 깊이 추정 참조 소프트웨어는 계속 발전하여 왔는데 부화소(sub-pixel) 단위 추정 기법[14], 색상 영상 분할을 통한 세그먼트 추출을 이용한 기법[15]이 추가되어 발전하고 있다. 그림2는 깊이 추정 참조 소프트웨어를 사용하여 추출한 깊이 영상이다.

본 논문에서는 사용자가 원하는 영역에서 의미있는 물체를 추출하는 방법에 대하여 제안한다. 의미있는 물체는 다음과 같이 가정한다.

① 사용자 입력 영역에서 중심에 위치한다. ② 유사한 깊이 정보를 가진다. ③ 관심영역에서 가장 자리는 배경일 가능성이 높다.

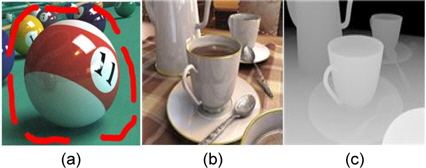

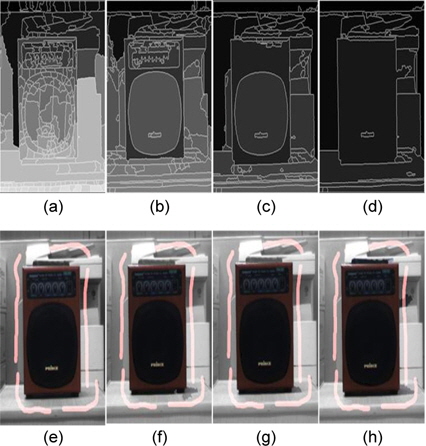

그림3(a)에서처럼 의미있는 물체는 사용자가 입력한 영역의 중심에 위치할 높은 확률을 가지고 있고, 가장자리 영역은 배경이 될 확률이 매우 높다. 그림 3(b)와 그림3(c)에서처럼 하나의 물체는 유사한 크기의 깊이정보를 가지고 있는 것을 알 수 있다.

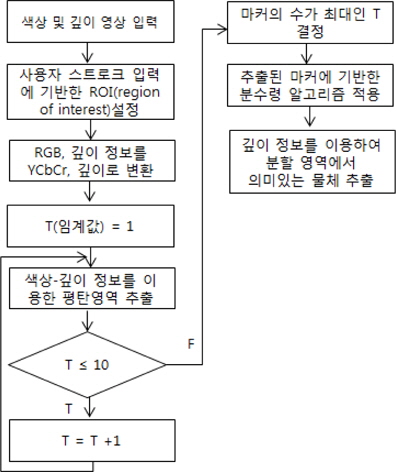

색상-깊이 기반의 평탄영역 추출, 적응적 임계값을 이용한 마커 영역 결정, 관심영역에서 물체 추출 방법을 통하여 사용자가 입력한 영역에서 의미있는 물체를 추출하는 방법을 제안한다. 사용자가 입력한 스트로크를 이용하여 ROI를 설정 한다. ROI 영역에 적응적 임계값을 이용한 분수령 알고리즘을 적용하여 ROI 영역을 과분할(over-segmentation) 하도록 설정한다. 위의 과정에서 색상과 깊이 정보를 이용한 평탄영역을 추출하고 적응적 임계값을 적용하여 마커의 개수가 최대가 되는 임계값을 결정한다. 또한 정확한 경계선 추출을 위해 분수령 알고리즘에 적용 시 색상정보만을 이용한 담금방식을 사용하여 분할 영역을 획득 하였다. 위의 과정에서 얻는 분할 영역은 깊이 정보를 이용하여 관심영역에서 의미있는 물체에 포함되는지를 판정함으로써 의미있는 물체를 추출 하였다. 제안 방법은 그림 4의 과정으로 이루어져 있다.

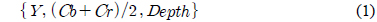

마커(marker)는 영상에서 동질성을 가지는 화소들에게 붙여진 라벨(label)로써 같은 특성을 가지는 영역이다. 마커 추출 과정은 형태학적(morphology) 연산을 통한 전처리 과정을 거친 후 형태학적 기울기를 이용하여 결정한다. 형태학적 기울기는 형태학적 필터를 사용하여 구한다. 기존 많은 방법들이 평탄영역 추출 과정에서 색상 정보만을 이용하여 추출하므로 주변 배경과 물체의 색상 정보가 유사할 경우 서로 다른 영역임에도 불구하고 서로 다른 영역으로 분할하지 못한다. 이러한 문제점은 색상정보와 함께 깊이 정보를 함께 이용하면 해결할 수 있다. 따라서 본 논문에서는 색상정보와 깊이정보를 함께 이용한 평탄영역을 추출하였다. 평탄영역 추출에 사용한 세 가지 성분은 식(1)과 같다. 색차성분인

식 (1)에 나타난 세 가지 성분에 대해 형태학적 연산을 수행함으로써 각 성분에 대한 형태학적 기울기를 구할 수 있다. 세 가지의 형태학적 기울기가 얻어지면 이 기울기 값을 기준으로 평탄영역인지를 판정하게 된다. 평탄영역이 일정 크기가 되면 이것이 마커가 된다.

한편 평탄영역인지를 판정하기 위해서는 그 기준이 필요한데 한 가지 성분에 대한 기울기만 존재하는 경우, 식(2)와 같이 정해진다.

여기서

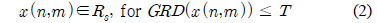

식(2)의 경우와 달리 세 가지의 형태학적 기울기를 가지는 경우에는 어떠한 기준에 의해 평탄영역으로 판정할 것인지가 문제가 된다. 본 논문에서는 세 가지의 기울기에 대해 큰 값을 가질수록 큰 가중치를 주어 합산함으로써 최종적인 기울기(GRD)를 결정하였다. 즉,

where

식(3)에서 큰 값을 가질수록 큰 가중치를 주도록 설정한 이유는 세 가지 성분 중 두 가지 성분이 작은 값을 가지더라도 한 가지 성분에서 큰 값을 가지면 이 화소는 평탄영역이 아님이 확실하므로 큰 값을 강조하기 위함이다. 결과적으로 각 성분에 대한 기울기 값을 크기의 순서대로 나열하고 각각에 대해 서로 다른 가중치를 부여함으로써 평탄 영역에 속하는 화소를 보다 정확하기 추출할 수 있다.

앞 소절에서 평탄영역에 속하는 화소들을 결정하였다면, 이 평탄영역에 속하는 화소가 형성하는 영역의 크기가 미리 설정된 크기 이상이 되면 이 영역이 마커영역이 된다. 식(2)에 나타난 문턱값은 평탄 영역을 결정하는 요소이므로, 결국 마커 영역을 결정하는 중요한 인자가 된다. 따라서 본 소절에서는 문턱값을 적응적으로 결정하는 방법에 대해 소개한다.

분수령 알고리즘에서 마커의 개수는 분할된 영역의 개수와 동일하다. 마커를 중심으로 미결정 영역 방향으로 담금 처리하기 때문에 마커 추출은 매우 중요하다. 의미있는 물체 추출을 위해서는 분할 영역의 개수가 많을수록 효과적으로 물체를 추출할 수 있다. 이를 위해 마커의 개수가 가능한 많이 추출되도록 임계값을 적응적으로 결정한다.

구체적으로 임계값이 될 수 있는 범위를 설정하고, 각 임계값에 대해 마커를 추출하고 그 마커의 개수가 최대가 되는 임계값을 최적의 임계값으로 결정한다.

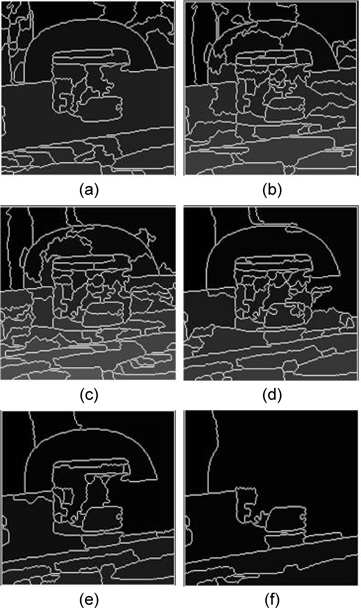

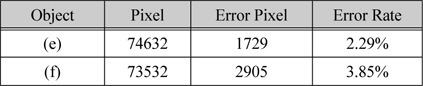

형태학적 기울기는 화소들이 유사한 경우 작은 값을 가지고, 경계지점에서는 기울기가 큰 값을 가진다. 이를 이용하여 임계값을 기준으로 마커 영역과 배경영역으로 구분하는 것이다. 임계값이 작을 경우 마커의 개수가 증가하고, 임계값이 큰 경우 주변 기울기 값이 동질성을 가질 확률이 증가하기 때문에 마커의 개수가 줄어든다. 하지만 임계값이 너무 작을 경우 영상에서 색상이나 깊이 정보의 변화가 다양할 때 형태학적 기울기는 임계값보다 작은 경우가 마커가 생기지 않을 수 있다. 그림 5은 여러 가지 임계값에 따른 마커 추출 및 영역 분할 결과이고, 표 1은 그림 5의 마커의 수와 분할된 영역의 수를 나타낸다. 그림 5에서 볼 수 있듯이 임계값이 너무 작거나 크면 분할된 영역의 개수가 적게 나타남을 알 수 있다. 따라서 가장 많은 분할 영역을 얻을 수 있는 임계값 설정이 필요하다. 결과적으로 임계값이 3일 경우 가장 많은 마커와 영역이 분할된 결과를 얻는다. 이 사례의 경우 최종적으로 최적의 임계값으로 3을 선택하게 된다.

그림 5의 마커 추출 결과

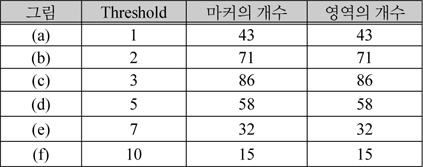

사용자가 입력한 관심영역에 대해 앞 소절에서 얻는 과분할 영역에 대해 깊이 정보를 기반으로 사용자의 관심 물체 영역인지 아닌지를 판정하여, 최종적으로 관심 물체 영역을 추출한다. 그 과정은 그림 6과 같다.

그림 6에서 처럼 ROI 전체를 의미있는 물체 영역으로 초기화한다. 가장자리 영역에서 내부 영역의 순으로 각 영역의 평균 깊이와 의미있는 물체로 설정된 영역의 평균 깊이를 비교하여

- 제외 대상 영역이 ROI의 가운데 좌표를 포함하고 있는 경우 제외되지 않는다. 이는 사용자가 추출하기를 윈하는 물체는 사용자 입력의 가운데에 위치한다는 가정에 기반한다. - 제외 대상 영역을 제외하였을 때 ROI 영역의 상당한 부분이 제외되는 결과를 가져올 때 제외되지 않는다.

위에서의 과정을 반복하여 의미있는 물체를 추출 할 수 있다.

한편, 사용자가 2개 이상의 물체를 추출하기를 원하는 경우 ROI가 서로 겹치는 경우가 발생하며, 분할된 영역이 서로 다른 물체 영역에 중복적으로 포함될 수 있다. 이 경우, 그 영역을 평균 깊이와 물체들의 평균 깊이를 비교하여 유사한 물체로 할당한다.

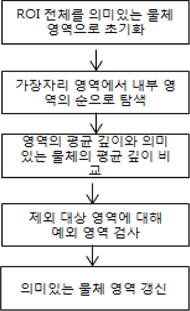

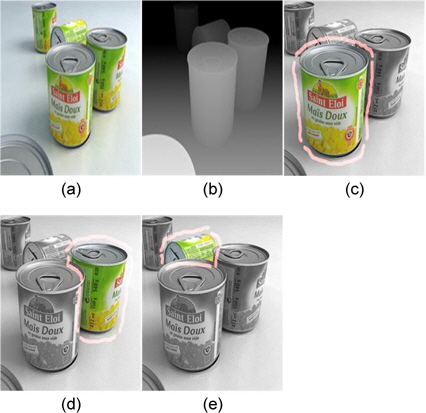

그림 7(a) 는 분할된 영상, 그림 7(b)와 그림 7(c)는 사용자 입력과 깊이 영상이다. 그림 7(d)와 그림 7(e)는 제안한 방법에 따라 관심영역의 가장자리와 사용자 입력 부분을 제거하고, 깊이정보를 통해 의미있는 물체를 추출한 결과이다.

제안한 방법의 적용을 위해서는 깊이 정보 추출이 필요함에 따라 스테레오 카메라(BumbleBee2)를 통해 좌, 우 영상을 입력 받아 카메라 렌즈의 왜곡 파라미터 추출 및 카메라 행렬 추출을 수행하였다. 파라미터 추출 단계를 거친 좌, 우 영상을 깊이 추정 참조 소프트웨어(DERS)를 사용하여 영상의 깊이 정보를 획득하였다. 영상의 깊이 정보는 0 ∼ 255 의 값을 가지며, 거리가 가까운 물체 일수록 255 값에 가까워지고, 먼 물체 일수록 0의 값에 가까워진다.

제안된 방법의 성능 평가를 위해 인공적으로 만든 깊이영상과 깊이 추정 참조 소프트웨어를 이용한 깊이 영상을 이용하여 실험을 하였다. 실험결과를 비교하기 위해 물체의 픽셀수와 제안한 방법을 통해 얻는 물체의 픽셀수를 비교하여 에러율(error rate)을 계산하였다.

4.1. 색상-깊이 기반 분할 방법과 색상 기반 분할 방법의 물체 추출 비교

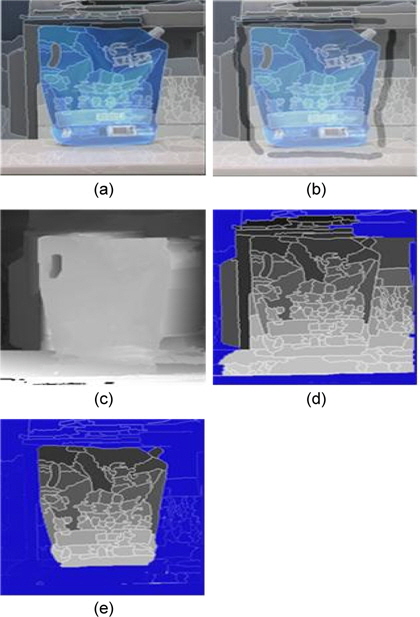

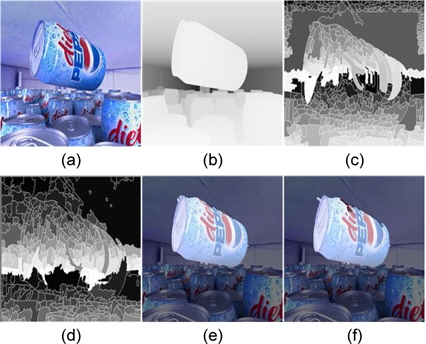

그림 8에서는 제안한 방법과 색상 기반 분할 방법의 물체 추출방식의 시각적인 비교 결과를 보이고 있다. 기존의 분수령 알고리즘을 이용한 영상 분할 방법은 색상 정보만을 이용하여 영역을 분할 하였다. 그림 8(d)와 그림 8(f) 기존의 분수령 알고리즘을 이용한 영역 분할 결과와 의미있는 물체를 추출한 결과이다.

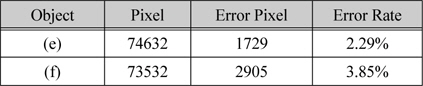

표 2는 그림 8의 물체 추출 결과에 대한 에러율을 표로 정리한 것이다. 색상 정보만을 이용한 기존의 방법보다 제안한 방법은 표 2에서 에러율을 통해 정확한 추출 결과를 얻을 수 있는 것을 알 수 있다.

그림 8의 에러율 결과

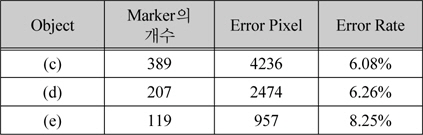

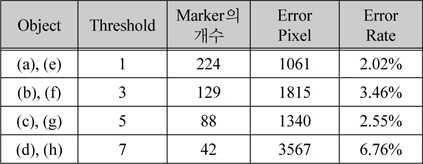

마커 추출 과정에서 임계값을 기준으로 하여 마커 영역을 추출한다. 마커 기반의 분수령 알고리즘은 마커의 숫자에 따라 분할된 영역의 개수가 정해지기 때문에 임계값의 변화에 따라 관심영역의 물체를 추출하는 결과가 다르게 나온다. 그림 9은 임계값에 따라 분할된 영역과 물체 추출 결과를 비교한다. 표 3은 그림 9의 결과를 정리한 것으로서 마커의 수가 많은 영상 분할 결과가 가장 우수한 결과를 얻는 것을 볼 수 있다.

적응적 임계값 변화 대한 물체 추출 결과

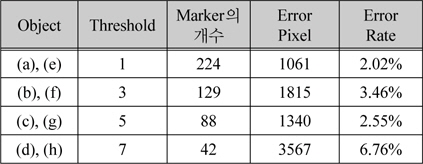

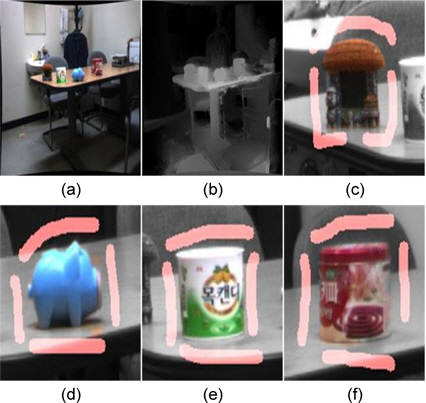

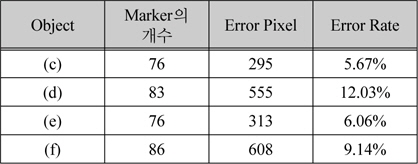

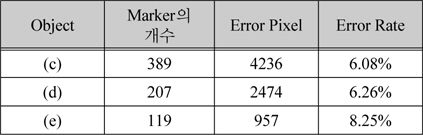

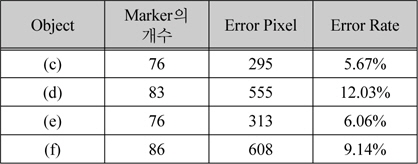

본 논문에서 제안한 방법을 통해서 관심 영역에서 물체를 추출하는 실험을 진행하였다. 그림 10은 입력영상과 인공적으로 만든 깊이 정보를 이용하여 실험을 수행한 결과이다. 이 결과에서 사용자의 관심영역이 2 개 이상 입력되었을 때도 관심 영역 안에서 물체를 효과적으로 추출함을 관찰할 수 있다. 그림 11은 스테레오 카메라를 통해 얻은 영상을 깊이 추정 참조 소프트웨어를 사용하여 깊이 영상을 획득하고 이를 통해 관심 물체를 추출한 실험 결과이다. 표 4 와 표 5는 그림 10, 그림 11의 적응적 임계값을 통해 결정된 마커의 수와 물체 추출 픽셀의 에러율을 나타낸다.

그림 10의 물체 추출 결과

그림 11의 물체 추출 결과

본 논문에서는 사용자의 입력, 색상, 깊이 정보를 이용하여 의미있는 물체를 추출하는 방법에 대해 제안하였다. 마커 추출 과정에서 색상 정보와 깊이 정보를 함께 이용함에 따른 형태학적 기울기값에 대한 성분별 가중치 적용과 적응적 임계값 결정 방법을 적용하여 효과적인 과분할 방법을 제안하였으며, 과분할된 영역에 대해 깊이 정보 기반의 영역 제거 방법을 통해 의미있는 물체 추출 방법을 제시하였다. 그 결과 사용자가 원하는 관심 영역에서 의미있는 물체 추출이 이루어졌음을 알 수 있었다.

또한 제안된 방법은 깊이 정보를 하나의 중요한 정보 중 하나로 사용함으로써 부정확한 깊이 추정에 따른 성능 저하가 존재한다. 이에 따라 영역의 경계를 결정할 시에는 색상 정보만을 이용하여 영역 경계를 결정하도록 하여 비교적 정확한 영역 경계가 결정됨을 알 수 있었다.