In remote gaze tracking system using infra-red LEDs, calibrating the position of reflected light is essential for computing pupil position in captured images. However, there are limitations in reducing errors because variable locations of head and unknown radius of cornea are involved in the calibration process as constants. This study purposes a gaze tracking method based on pupil-corneal reflection that does not require user-calibration. Our goal is to eliminate the correction process of glint positions, which require a prior calibration, so that the gaze calculation is simplified.

시선 추적 시스템은 눈의 움직임을 분석하여 시선의 방향을 예측하는 디바이스이다[1]. 모든 시선 추적 시스템은 카메라의 intrinsic 파라미터, 유닛간의 위치 관계, 눈의 파라미터 등을 정의해 주는 여러 가지의 캘리브레이션을 반드시 수행해야만 한다. 이러한 캘리브레이션 중에는 사용자가 실험 전에 거쳐야만 하는 과정도 있는데, 사용자가 시선을 추적하기에 앞서 여러 구역으로 나눠진 화면을 응시하는 방식으로 이루어진다. 특히, 간접 시선 추적 시스템 중 카메라로 촬영한 사용자의 눈 이미지를 분석하여 시선을 계산하는 feature-based 방식은 이러한 사용자 캘리브레이션 단계가 필수적이다. 조명이 각막에 한 번 반사된 것을 카메라로 촬영한 이미지에서 조명이 반사된 글린트의 위치가 실제로 그 조명 위치를 바라보았을 때의 동공 중심 위치와 다르기 때문이다.

본 논문은 적외선 조명을 사용하면서도, 사용자 캘리브레이션 과정을 생략할 수 있는 방법을 연구한다. 반사각에 의한 글린트(glint)위치의 차이에 영향을 받지않게 하면서, 시스템의 모델과 시선 계산은 단순하게 하여 실시간 연산이 가능하도록 하는 것이 목표이다.

다음의 2장에서 간접시선추적 시스템들과 이에 따른 캘리브레이션을 자세하게 설명한 후, 3장에서 본 논문이 제시하는 모델과 시선 계산 방법, 시스템의 구축 환경에 대해서 설명한다. 4장에서는 여러 사람에 대한 실험 결과를 통해 본 논문이 제시하는 모델에 대해 분석해 본다. 마지막 5장에서 본 논문에서 제시하는 방식을 정리한 후, 차후의 연구방향에 대해서 논의한다.

적외선 반사를 이용한 시선 추적 시스템은 HMD나 안경과 같은 얼굴에 착용하는 별도의 장치 없이 화면에 머무는 시선을 추적할 수 있기 때문에 사용자 입장에서 추적 과정이 자연스럽고 편안하다는 장점이 있다. 적외선 반사를 이용한 시선 추적 시스템 중 feature-based 방식은 카메라로 촬영한 사용자의 눈 이미지를 분석하여 동공의 경계, 조명이 반사된 위치 등을 추출해 시선을 계산한다[1]. 시선을 예측하는 과정에서 동공과 글린트는 매우 유용한 정보가 될 수 있는데, feature-based 방식에서는 카메라로 촬영한 이미지를 통해 이들을 비교적 쉽게 추출할 수 있다.

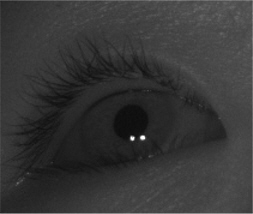

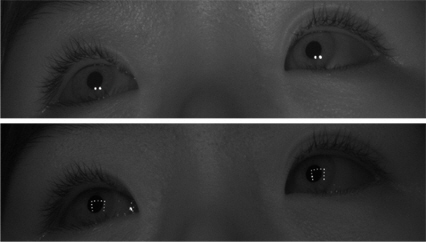

적외선 조명을 동공에 비추었을 때 카메라와 조명이 같은 축에 있지 않으면 그림 1과 같이 동공이 어두운 영역으로 확연히 드러나기 때문에 외관상 얼굴의 다른 부분과 구별된다[2]. 따라서 이를 이용해 동공의 중심좌표를 쉽게 얻을 수 있다. 또한 동공 주변에 적외선 조명의 반사가 일어난 글린트 부분을 이미지에서 추출할 수 있기 때문에 조명을 카메라와 화면 주변에 의도적으로 설치하여 시선을 계산하는 데 이용할 수 있다.

2.2. 시선 추적 시스템에서의 사용자 캘리브레이션의 의미와 필요성

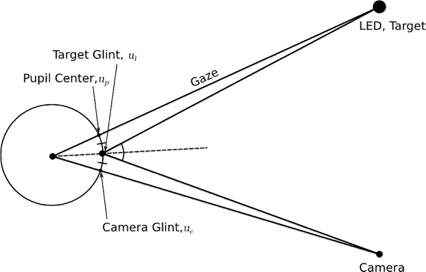

적외선을 이용한 시선 추적 시스템은 적외선 LED의 빛이 반사된 눈을 카메라로 촬영하여 얻은 정보로 시선을 계산하기 때문에 캘리브레이션이 필수적이다. 적외선 LED는 일반적으로 사용자가 바라보는 화면 주변과 카메라 내부 또는 렌즈 주변에 설치된다. 그림 2에서 사용자가 LED를 응시했을 때의 카메라에 설치된 LED의 글린트와 응시한 LED 글린트와의 관계를 나타냈다. 사용자가 LED를 응시했을 때 동공 중심은 LED를 향하게 된다. 이때, 카메라 글린트로부터 동공의 중심까지의 거리는 카메라 글린트로부터 응시한 LED 글린트까지의 거리의 두 배가 된다. 이때의 동공의 위치, 즉 LED글린트의 거리를 두 배로 한 위치를 기준으로 다른 곳을 응시하였을 때의 동공의 위치에서 시선 좌표를 역산 할 수 있는 것이다. 하지만 이것은 매우 이상적인 계산법으로, 실제로는 사용자가 LED를 응시하고 있더라도, 각막의 중심으로부터 동공의 중심을 잇는 선의 방향이 LED를 향해 있지 않으며 안구의 위치, 카메라와 LED의 위치에 따라서도 동공 중심과 글린트간의 거리 비율이 달라진다. 또한 촬영된 동공은 카메라 평면에 투영된 영상이므로, 동공을 촬영한 이미지에서의 글린트 사이의 거리가 각막에서의 길이에 비례하지 않는다. 따라서 이러한 차이를 보상하기 위한 캘리브레이션이 필요하다.

그림 2와 같이 글린트 사이의 거리가 이상적일 때 카메라와 조명의 글린트, 동공의 중심의 관계를 식 (1)과 같이 나타냈다.

[3]에서는

식 (1)에서의

그 다음, 4개의 보정된 글린트로 이루어진 평면위에 시선좌표가 있다고 가정한 후 Cross-Ratio 방식으로 시선을 계산하였다. 하지만 [4]와 [5]는 [3]의 문제점으로 4개의 보정된 글린트로 정의된 평면 위에 동공의 중심이 있지 않다는 점을 지적하였다. [4]는 화면상의 여러위치에 대한

기존의 연구들에서는 α 에 대한 캘리브레이션이 모델의 구조와 시선의 계산 방식상 불가피한 일이기 때문에 다양한 방법으로 수행되었다. 본 논문에서는 식 (2)에서 α 를 이용하여 보정한 후의 글린트

각막에서의 적외선 반사를 이용한 시선 추적 방식에서는 2.2에서 설명하였듯이

3.1. 배율 α의 추정이 필요 없는 시선 추적 시스템 모델 설계

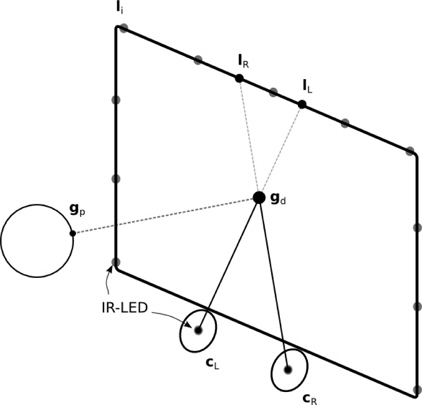

본 논문에서 제시하는 시선 추적 시스템은 그림 3과 같이 두 개의 카메라와 카메라 중심을 표시하기 위한 조명 및 화면 테두리의 조명을 이용한다. 사용자의 동공의 중심 gp와 왼쪽과 오른쪽의 카메라의 중심 cL, cR, 화면에서의 사용자의 시선으로 이루어진 두 평면은 동공의 중심과 화면의 시선을 지나는 선에서 교차한다. 각각의 카메라의 중심과 시선을 연결한 선을 화면의 끝까지 연장하여 화면의 테두리와 교차한 곳을 lL, lR이라고 할 때, 선 과 의 교차점은 화면의 시선 gd와 같다. 기존의 연구들은 이미지의 글린트의 위치를 보정하기 위해 캘리브레이션 과정을 통해 배율

따라서 시선 좌표를 구하기 위해서는 선 과 을 정의하기 위해 모니터 테두리와 교차하는 lL, lR의 좌표를 알아야 한다. 이는 화면 테두리에 여러 개의 적외선 LED를 설치함으로써 얻을 수 있다. 적외선 조명은 이미지 상에서 점으로 보일 수 있도록 최소한의 간격을 두고 설치해야 한다. 화면 하단 테두리에는 카 메라 두 대가 위치하고 있으므로 조명이 필요 없다.

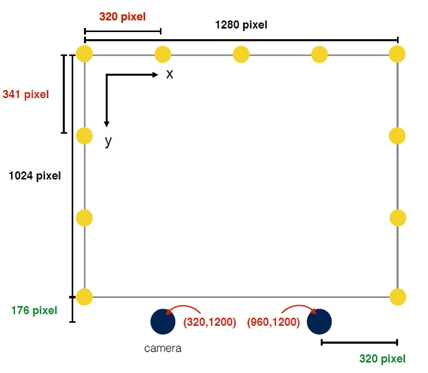

3.1에서 제시된 모델을 구현함에 있어서 먼저 정해야할 것은 모니터 테두리 조명의 개수이다. 촬영된 이미지에서 각각의 조명이 잘 구분되도록 하는 것이 중요하다. 본 논문에서는 Point Grey사의 Dragonfly2 카메라와 Computar사의 M1614-MP2 렌즈를 사용하였으며 적외선 LED는 파장 940nm, 화각 ±20°의 제품을 사용하였다. 실험적으로 조명의 개수를 조절하여 촬영해 본 결과, 총 11개의 조명이 적절하다고 판단하였다. 또한 카메라 위치를 이미지에서 알 수 있게 하기 위해 카메라 렌즈 주변을 따라 적외선 LED를 설치하였다. 실험에 사용된 모니터의 해상도는 1280×1024 pixel이다. 구현된 시스템의 실제 모습은 그림 4와 같다.

모니터 테두리의 11개의 조명을 동공에 비춘 모습을 보면, 동공 위에 걸쳐진 글린트가 많기 때문에 동공의 중심을 인식하기가 어렵다. 따라서 마이크로컨트롤러를 이용하여 카메라와 동기화하여 카메라 조명과 모니터 테두리의 조명을 매 프레임마다 번갈아 점등하도록 하였다. 동공의 중심과 글린트들의 위치는 모두 서브픽셀 단위로 계산하였다. 촬영한 동공의 모습은 그림 5와 같다.

최종 시선을 계산하기 위해, 시스템 구현 단계에서 정한 조명과 카메라의 위치를 실측하여 픽셀 단위로 나타낼 필요가 있다. 그림 6은 실측 비율에 따른 픽셀 단위의 레퍼런스 좌표를 나타냈다.

두 이미지 좌표계에서의 선 과 을 3.3.1에서 설명한 레퍼런스 좌표계로 변환하기 위해, 3.3.2의 과정으로 전처리된 글린트들을 이어 각각의 선으로 정의한 다음선 과 이 교차하는 점을 계산하였다. 이 점은 화면 테두리 LED와 LED 사이의 거리 비율로써 정의하였다. 각각의 이미지 좌표계였던 선 과 을 하나의 레퍼런스 좌표계로 변환하고 나면, 이 두 선의 교차점이 화면에서의 사용자의 시선이 된다.

실제 시선은 동공의 중심에서 관자놀이 방향으로 4에서 5°, 아래 방향으로 1.5°정도 차이가 있는 것으로 알려져 있는데[7], 양쪽 눈의 시선을 둘 다 구하면 가로방향의 차이를 보완할 수 있다. 한 이미지에 양쪽 두 눈이 다 보이도록 촬영했기 때문에, 왼쪽, 오른쪽 눈에 대하여 시선 좌표를 구한다음, 두 눈의 시선의 중간 좌표를 최종 시선으로 계산하였다.

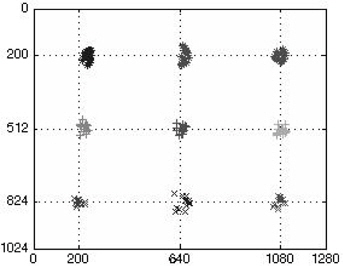

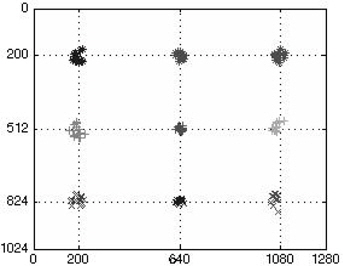

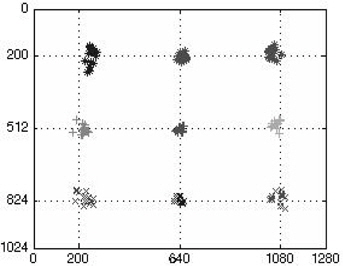

본 연구에서 구현된 시스템으로 3명의 실험 참여자에 대하여 시선 추적을 수행해 보았다. 화면과 실험 참여자와의 거리는 약 50~60cm 사이이며, 사용자의 머리의 움직임에 제한을 두지는 않았다. 모니터 화면에 표시된 3×3 의 총 9개의 점을 각각 바라보는 상태에서 시선 좌표를 실시간으로 계산하여 기록하였다.

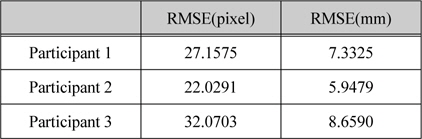

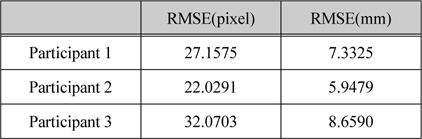

실험 참여자 3명에 대한 결과 그래프는 그림 7-10과 같다. 오차 계산을 위해 사용자에게 응시하도록 한 9개의 점의 위치와 시스템이 계산한 시선 값의 차이를 RMSE(Root-Mean Square Error)로 표현하였으며, 모든점에 대한 RMSE 평균값은 표 1과 같다. [3]의 실험에서는 실험 전 4개의 적외선 LED에 대하여 알파를 구하기 위한 캘리브레이션을 수행하였으며, Cross-Ratio 방식으로 시선을 추적 한 결과, RMSE는 약 11.21 mm 로, 본 논문의 시스템이 캘리브레이션 과정을 거치지 않았음에도 불구하고 비교적 작은 오차가 발생한 것으로 나타났다. 또한 논문[8]이 제시한 시스템은 캘리브레이션을 생략하는 대신 눈의 파라미터를 이용한 3차원 시선 추적 방식을 사용하였는데, RMSE 값은 사용자의 따라 8.40~16.55 mm 로, 본 논문은 3차원 모델의 RMSE 결과 값보다도 낮은 것으로 나타났다. 따라서 본 논문이 제시한 시선추적 시스템은 기존의 연구에 비하여 사용자 캘리브레이션을 수행하지 않으면서도, 기존의 시스템과 비슷하거나 더 높은 수준의 정확도를 가졌다고 볼 수 있다.

실험 참여자별 RMSE

적외선 조명을 이용한 간접시선추적 시스템에서는 촬영된 이미지에서 동공에 반사된 조명의 위치에 대한 캘리브레이션이 필수적이다. 시선 추적을 하기에 앞서, 사용자가 특정 지점 여러 개를 바라보도록 하여 시선 예측의 오차를 크게 보완할 수 있다. 하지만 이러한 과정은 사용자에게 불편을 줄 뿐만 아니라, 시선과 머리의 위치, 사용자의 눈 파라미터에 따라 달라질 수도 있는 변수가 고정된 값으로 계산에 포함되어 있기 때문에 오차를 감소시키는데 한계가 있다. 본 논문이 제시하는 모델은 사용자에 대해 캘리브레이션을 하지 않았음에도 불구하고, 기존의 연구들과 비슷한 정확도를 나타냈다는 점에서 유의미하다고 할 수 있다. 사용자 캘리브레이션 과정이 필요 없기 때문에 사용자와 실험자에게 추적과정이 수월하고, 고정된 상수 값이 계산에 포함되어 있지 않아 실시간 시스템에도 적합하다. 적외선 조명의 개수가 많아 동공인식에 어려움이 있기 때문에 2개의 프레임에 걸쳐 계산해야 한다는 단점이 있지만, 고속 또는 고해상도의 카메라를 사용하여 극복할 수 있다.

본 논문이 제시하는 모델에서 정확도에 영향을 미치는 가장 중요한 요인은 이미지에서의 동공의 중심과 글린트, 카메라의 위치의 정확도이다. 시선 좌표의 오차를 최소화시키기 위해서는 추후 연구에서 이러한 요소들의 정확도를 수치상으로 나타내 볼 필요가 있다. 또한, 두 눈 사이의 중간값을 시선으로 함으로써 동공의 중심과 실제 시선과의 차이를 줄였지만, 아래 방향으로의 차이는 여전히 남아 있어 이 점을 보완해야 할 것이다.