With the development of computer technology, augmented reality (Augmented Reality, AR) technology in the future, one of the main directions of development of human interface technology is emerging. On augmented reality based on the design and implementation of a digital business card system.

In this paper, a Smartphone is simply information through recognizable digital business card contains information about the system. Digital business card system is compared to the way existing hardware in a way visually-based high precision. In addition, registered as a 3D computer vision of augmented reality technology skills and real-world situations convergence technology for research.

Future research, 3D electronic map for Smartphone apps as of the application user interface on the side for research is needed.

현재 자연과학기술과 인문과학을 전시하는 디지털과학기술관과 박물관 등에는 가상 책, 디지털 올림픽 전시관, 음성 인식 로봇, 건축 가상 표현, 상호 작용 환상, 카메라 게임 등이 전시되어 있다[1]. 스마트폰(Smartphone)은 PC와 같은 기능과 더불어 편의 기능을 제공하는 휴대폰으로 전 세계적으로 스마트폰이 일반 휴대전화를 대체하고 있다. 그러나 AR를 이용하는 앱어플리케이션이 많이 없고, 무선 네트워크가 없는 환경에서 목표물 인식과 내비게이션 기능을 요구한다[2].

따라서 본 논문에서는 증강현실 기술을 스마트폰에 적용시켜 디지털 명함과 3D전자지도를 이용하여 개인 정보, 영역 설명, 3D 지도 등을 얻을 수 있는 시스템을 설계 및 구현하였다.

본 연구의 목적은 사용자가 스마트폰을 통하여 정보를 얻고, 사용자로 하여금 신속히 낯선 환경 속에 융합할 수 있게 하며 또한 사용자와 3D 모델간의 상호 작용을 만족할 수 있는 전자 명함 내비게이션 시스템을 설계 및 구현하는 것이다.

AR시스템 중 가상 3D 모델의 렌더링 방면에서 OpenGL은 구조가 간단하고 동영상 디자인을 쉽게 실현할 수 있는 가상 3D 모델을 제공한다. 카메라 내부함수와 외부함수를 이용하여 OpenGL 중 가상 카메라의 위치와 방향을 설정하여 가상 3D모델로 하여금 정확하게 실제 환경에 렌더링 되게 한다[3-5].

AR시스템 중 두 마커 물체의 충돌 상황을 검사 할 때 주로 마커 물체의 두 세계 좌표계 원점이 카메라 좌표계에서의 거리가 설정한 충돌거리의 값보다 작은 지를 검사한다. 만약 설정한 충돌거리보다 작으면 두 가상물체는 충돌이 존재 한다 보고 그래픽 제작 모듈은 이미 설정한 동영상을 플레이한다. 그렇지 않으면 충돌이 없다고 본다.

충동 감지 모듈은 검사한 결과를 사용자 상호 작용 모듈에 입력하여 사용자 상호 작용 모듈이 입력된 함수의 사용자 상호작용 의미를 분석한다[6].

AR시스템은 그래픽 영상기술, 멀티미디어 제어기술과 결합하여 생생한 AR환경을 제작하여 사용자가 현실 세계에 대한 감지 능력을 제공하며 실질적으로 새로운 환경을 제공한다. 멀티미디어 제어기술은 주로 오디오와 비디오 방면에서 사용자가 현실세계에 대한 인지능력을 증강한다.

컴퓨터 시각 중 카메라 교정기술은 실제 화면에서 영상 화소 생성하는 과정이다. 이 과정을 분석하기 위해 카메라 영상의 모델을 수립하여 2D영상 정보로부터 3D화면의 대응관계 알아야 하며 이 관계를 카메라의 내부함수와 외부함수로 마커 해야 한다[7].

카메라 모델은 일반적으로 두 가지 종류가 있다. 한 가지는 공용 원근 투영 카메라 모델이고 다른 한 가지는 방사형 왜곡을 기반으로 한 Tsai 카메라 모델이다[8].

공용 카메라 모델을 기반으로 한 카메라 교정기술은 원근 투영의 카메라 모델을 수립하여 카메라의 외부함수와 내부함수를 구한다.

3D 장면 속의 물체는 조명의 영향을 받을 뿐만 아니라 주위환경의 영향도 받으며 주위 환경의 영상을 반사할 수 있다. 실제로 한 폭의 물체 주위환경 장면을 포함한 텍스쳐를 물체표면에 매핑시키면 일정한 비율로 물체 주위환경의 반사를 시뮬레이션 할 수 있으며 광선추적 등 복잡한 기술을 사용하지 않아도 된다. 환경반사를 실현하고 시스템이 3D 실시간 동적인 장면의 렌더링 속도를 높이기 위해 GPU 프로그래밍 기술을 사용한다[9].

본 장은 증강현실을 기반으로 디지털 명함과 3D전자지도를 설계한다. 여러 개의 고정카메라를 통해 시스템 중의 표기를 식별하고 3D 실험기기 모델을 마커 위에 투영한다. 동시에 물체의 심도 정보에 대한 검사를 통해 조명과 사용자가 보낸 상호작용 정보를 계산하여 가상물체와 현실 환경의 관계 처리를 진행한다.

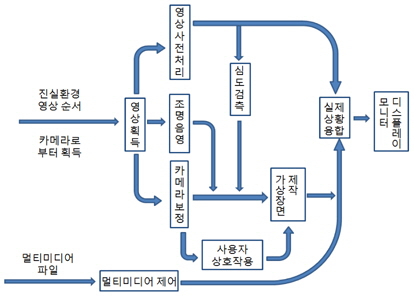

본 시스템은 9개의 서브 모듈로 구성되는데 그림 1과 같다. 이 밖에 조명 제어, 조명 계산, 투영 제작, 사용자 정보관리 등 4개의 확장 서브 모듈이 있다.

본 절에서는 주요 서브시스템 모듈에 관한 구현 원리와 구현 세부사항에 대해 설명한다.

본 모듈의 주요 성능은 영상 입력 장비에서 비디오 스트리밍을 수집하여 비디오 스트리밍에서 비디오 영상을 얻는다. 증강현실 시스템의 영상 수집은 실시간성, 정확성에 대한 요구를 만족해야 한다.

이 모듈은 3D 등록 서브 모듈과 실제 상황 융합 서브 모듈에게 아주 중요한 기초 데이터를 제공한다. 이는 이미지 분할, 에지 검출 등 영상처리 방법을 통해 수집한 영상에 대해 처리를 진행하여 작업환경의 설정내용 중에서 미리 설정 중에 설치한 마커를 식별해내는 것이다. 시스템이 3D 등록 단계에서의 실시간성과 실제상황 융합 모듈 중 완전 융합의 정확성에 대해 직접적인 영향을 끼친다.

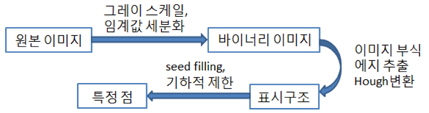

이 모듈의 3개 중요한 단계는 영상 전처리와 영상 분할, 에지 검출과 특징 점 추출이다(그림 2).

증강현실시스템 중 영상 분할, 에지 검출과 윤곽선을 추출한 후 결과를 마커 식별 서브모듈로 전달한다. 모드 매칭 연산에 근거하여 시스템으로 하여금 카메라의 비디오영상으로부터 미리 준비한 마커를 정확하게 식별하게 하며 동시에 마커의 ID번호를 제공한다. 시스템 중 그래픽 디스플레이 서브모듈 입력 함수의 일부분으로 그래픽 디스플레이 서브모듈에서 미리 준비한 3D모델을 특정한 표기에 정확하게 나타나게 하여 현실 환경에 대한 증강을 실현한다.

이 모듈은 영상 비교 모듈의 출력결과를 입력 데이터로 사용한다. 카메라의 내부 함수 측정 연산과 카메라 외부 함수 측정 연산을 통하여 프로그램에서 사용되는 표기의 3D위치와 방향을 계산하여 마지막으로 카메라의 외부 함수를 추출결과로 실제 상황 결합 서브모듈에 입력하고, OpenGL중의 가상 카메라로 현실 세계 중의 카메라를 시뮬레이션 하여 양호한 가상과 현실 환경의 완전융합 장면을 생성한다. 마지막으로 3D 가상 동영상 모델을 특정한 마커에 렌더링하여 증강현실의 효과를 실현한다.

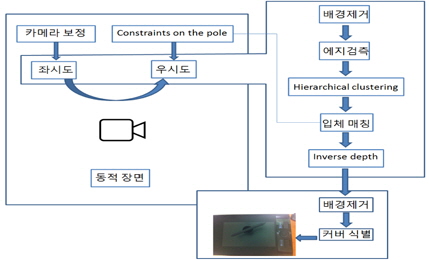

심도 검사 서브모듈은 현실세계와 가상세계를 연결하는 교량 역할을 수행한다. 주로 photo hull기술을 이용하여 공간 점의 심도정보를 판단한다. 공간조각 계산법 중 우선적으로 현실세계 중 하나의 3D공간을 확정해야 한다. 한 점이 여러 영상에서의 심도정보의 직선 방정식을 계산하고 방정식을 연계하여 최소제곱법을 이용하여 영상 점의 심도정보를 계산해 낸다. 심도 검사 서브모듈의 흐름도는 그림 3과 같다.

그래픽 제작 서브모듈은 시스템이 가상 3D모델에서 실시간으로 렌더링을 실현한다. 이 모듈의 개발 키트는 주로 OpenGL과 OpenVRML이 포함된다. OpenGL은 3D 모델 렌더링 개발 키드이며 여러 가지 성숙된 기술과 기능이 포함되며 주로 3D장면 중 3D모델을 구성하고 이런 모델들의 공간 위치관계를 관리한다. 또한 3D모델의 아핀 변환(Affine Transform)을 지원하고 풍부한 칼라 선택 기능을 제공하고 조명 시뮬레이션과 텍스쳐 매핑(texture mapping)을 지원한다. 안티에얼리어싱(antialiasing) 등 기술은 실제 상황 결합 모듈을 지원하여 완벽한 융합을 실현하여 비트맵을 표현할 수 있으며 이중 버퍼링 기술을 응용하여 동영상 렌더링을 실현한다.

실제 상황 융합 서브모듈은 주로 전경과 가상 환경과의 융합, 에지 융합 등 작업을 수행한다. 이 모듈은 조명, 음영, 전경칼라 증강 등 시각효과를 환경의 수요에 따라 시스템에 추가하여 증강현실 시스템 중 장면의 현실감을 증가한다.

이 모듈은 사용자를 위해 가상물체와 직접 상호작용 할 수 있는 방식을 제공한다. 한 가지는 사용자가 손으로 가상물체와 상호작용하는 것이다. 이런 상호작용 방식은 주로 심도 검사 모듈의 추출 결과를 응용하여 만약 심도 검사 모듈에서 실제 손을 발견하였다면 이 결과를 입력 함수의 형식으로 사용자 상호작용 모듈에전송하여 사용자 상호작용 모듈은 함수를 분석한 후 상호작용 시맨틱(semantic) 신호를 추출한 후 이 신호를 함수 형식으로 그래픽 렌더링 모듈의 동영상 컨트롤 함수에 전송한다. 이때 표기 위에 가상 3D모델이 디스플레이 되며 사용자는 손에 생성된 3D 모델로 시스템 중의 다른 가상물체와 상호작용을 진행한다.

본 논문의 구현 환경은 듀얼코어 이상의 CPU와 2GB이상의 메모리를 사용하는 APPLE 사의 MacOS 10.7에서 Macbook pro를 사용하였고, iOS5 이상 iPhone4를 사용하여 구현하였다.

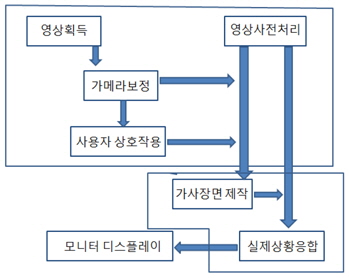

시스템 구성도 에서는 현실 환경 속에 장착 한 여러개의 고정카메라를 통해 시스템 중의 표기를 식별하고 3D 실험기기 모델을 표기 위에 투영한다. 동시에 물체의 심도정보에 대한 검사를 통해 조명과 체험자가 보낸 상호작용 정보를 계산하여 가상물체와 현실 환경의 연결 관계 처리를 진행한다. 구성도는 그림 4와 같다.

사용자는 스마트폰을 통해 본 시스템을 사용하여 개인 정보를 획득, 영역 설명, 3D 장면 지도 등을 얻을 수 있어 사용자로 하여금 신속히 낯선 환경 속에 적응할 수 있게 하며, 또한 사용자와 3D 모델간의 상호 작용을 만족할 수 있다.

대부분 명함은 사람들의 이름, 직위 등 간단한 정보가 적혀있을 뿐 상세한 정보를 표현하기에는 부족하다. 그러므로 본 논문에서는 마커를 이용하여 명함에 더욱 많은 정보를 나타낼 수 있게 한다.

사용자는 스마트폰의 카메라로 마커를 인식하여 3D 디지털 명함의 모델을 표기 위에 투영하여 스마트폰을 통하여 가상물체와 현실세계가 융합한 장면을 볼 수 있다(그림 5, 6).

낯선 도시에서 자기가 위치하고 있는 장소를 알기 위해 지도 혹은 휴대폰 내비게이션 등을 통해 쉽게 실현할 수 있다. 하지만 구조가 복잡한 빌딩에서 특정 지점을 찾기에는 어렵다. 본 시스템은 스마트 폰을 이용하여 사용자로 하여금 더욱 편리하게 원하는 정보를 얻게 한다. 본 시스템에서는 보편적으로 유행하는 GPS를 사용하지 않고 마커를 이용하여 위치추적을 실현하였다. 이유는 GPS 신호가 나쁜 곳이 많으며 데이터 낭비가 많다. 하지만 본 시스템은 보다 빠른 속도와 인터넷이 없는 환경 하에서도 위치추적을 실현할 수 있다. 사용하는 마커는 대부분 문패이며 모든 문패는 서로 다르기에 아주 쉽게 식별해낼 수 있다. 사용자는 휴대폰 카메라를 통해 마커를 인식하여 휴대폰에서 위치의 3D장면 지도를 볼 수 있으며 위치하고 있는 장소는 다른 색깔로 마커하여 구분한다(그림 7).

본 시스템은 마커를 사용하여 디지털 명함뿐만 아니라 전지지도를 볼 수 있다. 이 전자지도의 근처 마커 표기 기능에 이 구역에 대한 설명을 추가할 수 있다(그림 8).

증강현실 시스템 중 추적시스템은 아주 중요하다. 보통 AR시스템은 두 가지의 추적방식을 사용할 수 있다. 하나는 하드웨어 장비를 기반으로 한 위치추적기술, 다른 한 가지는 본 논문의 방식으로 컴퓨터 시각을 기반으로 한 위치추적기술이다. 하드웨어 기반으로 한 위치 추적 방식은 값이 비싸고 체적이 너무 방대하며 추적과정에 간섭을 받기 쉽다. 시각을 기반으로 한 추적방식은 부가적인 하드웨어 장비가 필요 없으며 추적 정밀도가 높고 시스템의 등록 오차를 최소화 할 수 있지만 단점이라면 실시간성이 약하고 대량의 영상처리와 식별 작업이 필요하다. 그러나 컴퓨터 시각기술의 신속한 발전에 따라 이상의 문제는 점차 극복되고 있다.

본 논문에서는 증감현실 기술을 기반으로 3D 전자지도를 가지는 디지털 명함 시스템을 설계 및 구현하였다. 시각 기반 방식으로 기존 하드웨어 방식에 비해 값이 저렴하고 정밀도가 높은 장점을 가진다. 또한, 증강현실 기술 중 컴퓨터 시각의 3D 등록 기술과 실제상황 융합 기술에 대해 연구를 하였다. 3D 등록기술 중 마커 식별의 안정성 문제를 위해 마커의 방향성 문제를 해결하였고, 마커 식별공간을 확장하는 방법으로 3D 등록기술로 더욱 좋은 안정성을 가지게 하였다. 디지털 명함과 3D 전자지도와 같은 실제 상황 융합 모듈 중에서 가상 물체와 실제 환경의 위치 일관성은 이미 아주 좋은 효과를 얻었다. 이로 인해 AR시스템 중 전자 명함에 적용하여 좋은 실험결과를 얻었다. 제안한 디지털 명함은 스마트 폰을 통하여 간단하게 정보를 인식할 수 있어 스마트 폰의 점유율과 성능을 생각할 때 매우 유용하리라 사료된다. 또한, 3D전자 지도는 스마트 폰을 매개체로 하여 더욱 편리하게 정보를 얻게 되었다.

향후 사용자가 어떻게 가상세계의 물체와 자연스러 운 상호작용을 하는가에 대해 연구가 이루어져야 할 것이다.